Einführung

Kontakte, Spenden, Mitglieder oder Events managen, Kampagnen durchführen, mit den eigenen Zielgruppen kommunizieren oder Daten zur Wirkungsmessung erheben: Immer mehr zivilgesellschaftliche Organisationen nutzen die Open-Source-Software CiviCRM. So sind für viele Mitarbeiter*innen und engagierte CiviCRM-Daten die Grundlage ihrer täglichen inhaltlichen Arbeit geworden.

Doch wie können zivilgesellschaftliche Akteur*innen in CiviCRM gesammelte Daten für ihre Arbeit nutzen - zur Fördermittelakquise, zur Berichterstattung, zur Wirkungsmessung, zur Verbesserung ihrer Prozesse oder zum organisationellen Lernen? Mit welchen technischen Ansätzen können CiviCRM-Daten ausgewertet, analysiert und visualisiert werden?

Diese Fragen zu erkunden, war das Ziel eines internen Datenvorhabens, welches ein Team des Civic Data Labs im Sommer 2025 durchgeführt hat. Ausgehend von Gesprächen und schriftlichen Austauschen mit zivilgesellschaftlichen Akteur*innen zu ihrer CiviCRM-Nutzung recherchierten wir Tools und führten verschiedene technische Experimente durch, in denen wir Testdaten einer eigens eingerichteten CiviCRM-Instanz analysierten und visualisierten.

Dieses Lernmaterial dokumentiert die Ergebnisse dieses Datenvorhabens. Es richtet sich vor allem an Personen, die CiviCRM bereits nutzen und ihre CiviCRM Daten analysieren (wollen). Aber auch Personen, die überlegen, CiviCRM in ihrer Organisation einzuführen, oder die an Open Source Software oder gemeinwohlorientierter Datennutzung interessiert sind, sind herzlich willkommen, hier duchzustöbern.

Wie sollte dieses Lernmaterial gelesen werden?

Aufbau

Hauptteil dieser Ressource ist die Erklärung von Ansätzen zur Analyse und Visualisierung von Daten aus CiviCRM mithilfe von Toolkombinationen und anhand von konkreten Beispielen in Kapitel 2️⃣. Dabei wird auf detaillierte Beschreibungen und Erklärungen zu Tools verwiesen, die sich im Kapitel 3️⃣ befinden.

Mit Tools meinen wir technische Mittel unterschiedlicher Art: von Komponenten innerhalb von CiviCRM, über externe Anwendungen bis hin zu Programmiersprachen. Gemeinsam ist diesen Tools, dass sie eine Rolle bei der Analyse oder Visualisierung, bzw. der Herstellung der Möglichkeit zu letzterem spielen. Für die Definition dieser Rollen nutzen wir das Konzept des Datenlebenszyklus, das wir im Kapitel 1️⃣ vorstellen.

In Kapitel 4️⃣ ziehen wir ein Fazit zu unseren Experimenten.

Hinweise zur Bedienung

Zur Navigation kann die Seitenleiste und/oder die Pfeile am Ende der Unterseiten verwendet werden. Mit der 🔍 Suchfunktion kann die Seite nach Begriffen durchsucht werden.

Symbolerklärungen

In diesen Boxen erscheinen Tipps oder Informationen, die für das Verständnis des Beschriebenen direkt relevant sind.

Hier zitieren wir etwas und nennen die Quelle in den Fußnoten.1

Lebenszyklus von CiviCRM-Daten

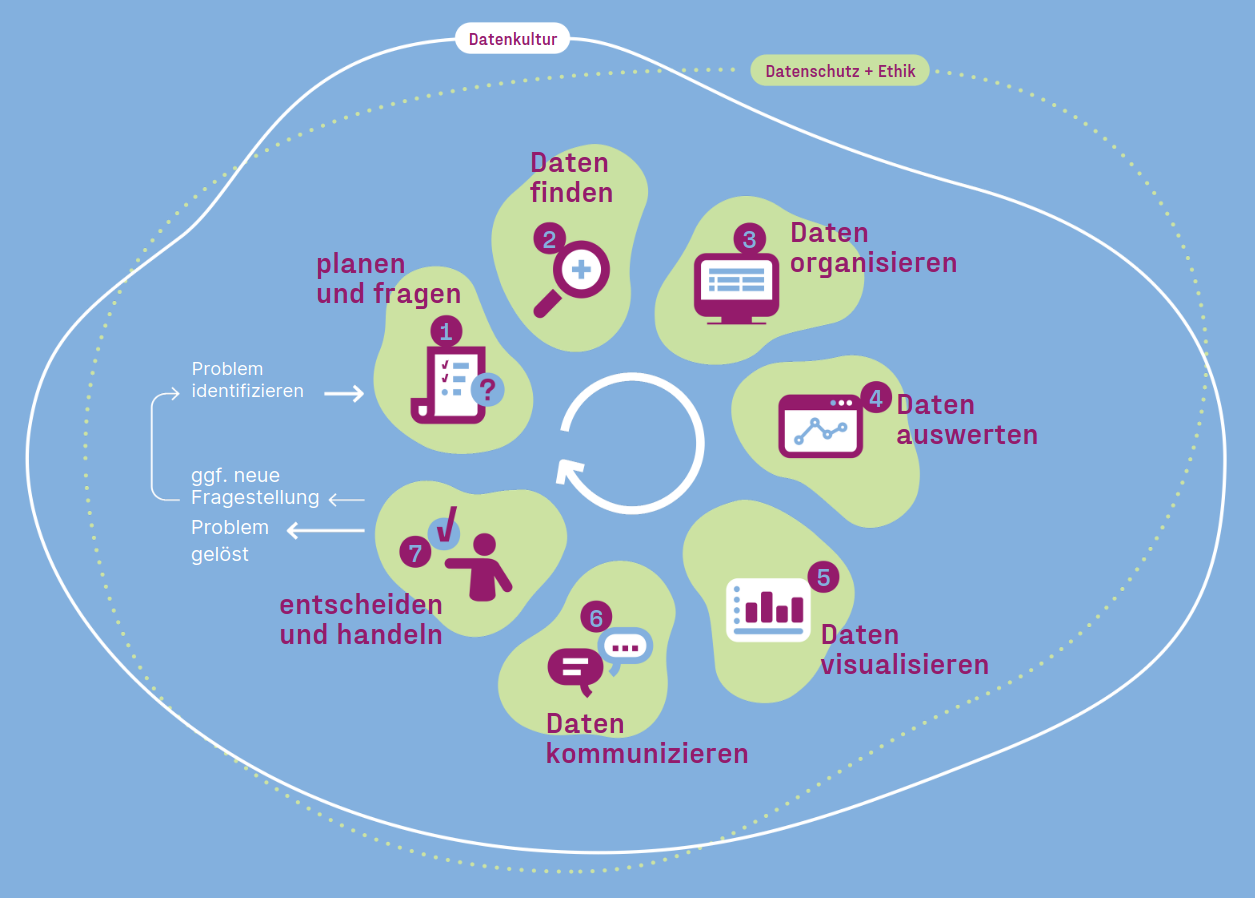

Der Datenlebenszyklus, visualisiert in der obigen Grafik, gibt einen Überblick über den Ablauf einer Datenanalyse - von der Planung bis hin zur Umsetzung. Wir werden dieses Konzept hier nicht genauer erklären und verweisen bei Bedarf und Interesse auf die entsprechende Informationsseite der Website des CDL.

Wir verwenden den Datenlebenszyklus hier, um Tools einzuordnen und fokussieren uns dabei auf die folgenden Aspekte:

Planen und fragen 🗺️

Welche Fragen will ich mithilfe von Daten beantworten? Welche Daten brauche ich?

Bei unserem Projekt gingen wir größenteils davon aus, dass interessierte Organisation schon Daten haben und auch wissen, welche Fragen sie an die Daten stellen wollen. Allerdings können manche Fragestellungen nur beantwortet werden, wenn man die in CiviCRM erfassten Daten um eigene Felder erweitert.

🗺️ Erweiterung von CiviCRM-Daten

Daten organisieren 🧹

Wo und wie werden Daten gespeichert? Wie werden sie verwaltet und wie werden sie bereinigt? Wie werden Datenflüsse zwischen Tools ermöglicht?

→ Daten in CiviCRM liegen in einer SQL-Datenbank bereits organisiert vor, was als Ort zur Speicherung, Organisation und Verwaltung von Daten häufig ausreicht. Wenn wir allerdings auf externe Tools zur Analyse und/oder Visualisierung zurückgreifen wollen, werden Ansätze und Methoden aus dem Bereich des Data Engineering und Data Modeling relevant, z.B. die Verwendung der CiviCRM API, einer Managed Datenbank oder die Integration von mehreren Tools mithilfe von Workflow Automation Tools.

🧹 CiviCRM Datenbank 🧹 Managed Datenbank 🧹 CiviCRM-API 🧹 Workflow Automation Tools 🧹 MS Power Query 🧹 Google Apps Script 🧹 Python

Daten auswerten 🔢

Wie werden Daten analysiert? Wie werden Ergebnisse analysiert?

→ CiviCRM Daten können unterschiedlich ausgewertet und analysiert werden: Von einfachen deskriptiven Analysen über tiefergehende Analysen hin zu komplexen Machine-Learning-Modellen zur Vorhersage von Spenden. Wir haben uns in unserer Arbeit überwiegend auf einfache Auswertungen fokussiert, da diese am übertragbarsten sind.

🔢 CiviCRM SearchKit 🔢 Excel, Google Sheets & Co. 🔢 Metabase & andere BI Tools 🔢 Python & R 🔢 CiviCRM Reports/Berichte

Daten visualisieren 📊

Wie werden Daten visuell ansprechend und passend für die Zielgruppe aufbereitet?

→ Viele Organisationen möchten ihre CiviCRM-Daten nicht nur auswerten, sondern auch in Datenvisualisierungen oder Dashboards aufbereiten.

📊 CiviCRM ChartKit 📊 Excel, Google Sheets & Co. 📊 Metabase & andere BI Tools 📊 Python & R 📊 Civisualize

Daten kommunizieren 💬

Wie werden Ergebnisse zielgruppengerecht kommuniziert und geteilt?

→ Auswertungen von CiviCRM-Daten können unterschiedliche Zielgruppen haben: man selbst, die eigene Organisation bzw. das eigene Team, die breite Öffentlichkeit, existierende Fördermittelgeber oder potenzielle Sponsor*innen. Je nach Zielgruppe(n) ergeben sich unterschiedliche Anforderungen an die Tiefe und Komplexität der Analyse, an das Design der Visualisierungen, an die Kommunikationswege.

Das Kommunizieren von Daten und Ergebnissen von Datenauswertungen ist eine Kunst bzw. ein Handwerk an sich1. Wir beschränken uns hier nur darauf, inwiefern Analyse- und Visualisierungs-Tools die Möglichkeiten bieten, Ergebnisse zu teilen, und inwiefern sie Ansprüche an Design und Professionalität erfüllen. Deshalb listen wir hier nicht separat “Datenkommunikationstools”.

Datenschutz

→ Da in CiviCRM fast immer personenbezogene Daten gespeichert werden, bildet Datenschutz einen wichtigen Rahmen für die Auswertung von CiviCRM-Daten. Dies ist vor allem relevant, wenn Daten außerhalb von CiviCRM weiterverarbeitet werden. Wir haben bei unserer Arbeit darauf geachtet, Tools zu priorisieren, die Datensouveränität ermöglichen.

Trotzdem haben wir auch Software von außereuropäischen Anbietern in unsere Recherche miteinbezogen. Wenn ihr diese Tools nutzen möchtet, empfehlen wir euch, Daten in CiviCRM oder europäischen Umgebungen so weit zu aggregieren, dass kein Rückschluss mehr auf Individuen möglich ist.

-

Das E-Learning Datenvisualisierung und Storytelling des Civic Data Labs gibt einen guten Einstieg ins Thema. ↩

Ansätze: Toolkombinationen

Um Daten in CiviCRM zu analysieren anzugehen, lassen sich fast immer mehrerer Lösungen finden. Es gibt kein „richtig“ oder „falsch“ – entscheidend ist, welche Tools und Methoden für euch am besten funktionieren.

Grundsätzlich könnt ihr unterscheiden, welche Schritte des Datenlebenszyklus ihr in CiviCRM und/oder extern abbildet:

- Alle Schritte in CiviCRM umsetzen (von Datenorganisation bis zur Datenvisualisierung).

- Daten organisieren und auswerten mithilfe von CiviCRM, Visualisierung und Kommunikation mit externen Tools.

- Nur Datenorganisation in CiviCRM, Auswertung, Visualisierung und Kommunikation mit externen Tools.

- Daten extern organisieren (z. B. in einer zusätzlichen Datenbank oder einem ETL-Tool), Auswertung und Visualisierung ebenfalls extern.

Generell gilt: CiviCRM ist primär ein CRM, kein Datenanalyse- oder Visualisierungstool. Je höher eure Anforderungen an die Auswertung sind, desto eher solltet ihr externe Tools hinzuziehen.

Darüber hinaus hängt die Wahl des Ansatzes von euren Ressourcen, Zielen und Anforderungen ab:

- Finanzielle Ressourcen eurer Organisation

- Bestehende technische Infrastruktur

- Vorhandene Fähigkeiten sowie Bereitschaft und Zeit, Neues zu erlernen

- Zielgruppe der Auswertung: interne Nutzung oder externe Stakeholder?

- Anforderungen an die Auswertungsergebnisse: Format, Design etc.

- Flexibilität: Soll explorativ gearbeitet oder nur eine festgelegte Auswertung durchgeführt werden?

Wir beschreiben Vor- und Nachteile der Tools und Ansätze, um euch bei der Entscheidung zu unterstützen – damit ihr eure CiviCRM-Daten bestmöglich auswerten könnt.

Aufbau dieses Kapitels

Bei der Sortierung der nachfolgenden Unterseiten haben wir die Ansätze nach Komplexität im Sinne von Menge an benötigten technischen Kenntnissen und Komponenten geordnet.

- Der am wenigsten komplexe Ansatz ist die ausschließliche Verwendung von CiviCRM-eigenen Tools wie SearchKit und ChartKit zur Analyse & Visualisierung.

- Wenn ihr externe Tools wie z.B. Metabase benötigt, ist deren Anschluss am einfachsten mit einer direkten Verbindung mit der CiviCRM-eigenen Datenbank möglich.

- Wenn eine direkte Anbindung an die CiviCRM-Datnbank nicht möglich ist (z.B. aus Sicherheitsgründen), könnt ihr selbst die API verwenden, um CiviCRM-Daten in anderen Tools zu analysieren, z.B. mithilfe von Excel oder Google Sheets

- Der Kategorie von Ansätzen, die am meisten der in der Disziplin des Data Engineering verbreiteten ETL-Prozessen (Extract, Transform & Load) gleichen, haben wir dabei mit einer eigenen Erklärungsseite ausgestattet.

SearchKit & ChartKit

Wir verwenden die Tools, die bereits in CiviCRM vorhanden sind, um Daten zu analysieren und zu visualisieren.

🧹 daten-organisieren: CiviCRM Datenbank

🔢 daten-auswerten: SearchKit

📊 daten-visualisieren: ChartKit

Voraussetzungen

Anleitung

Setup

kein weiterer Setup nötig. :)

Datenauswertung

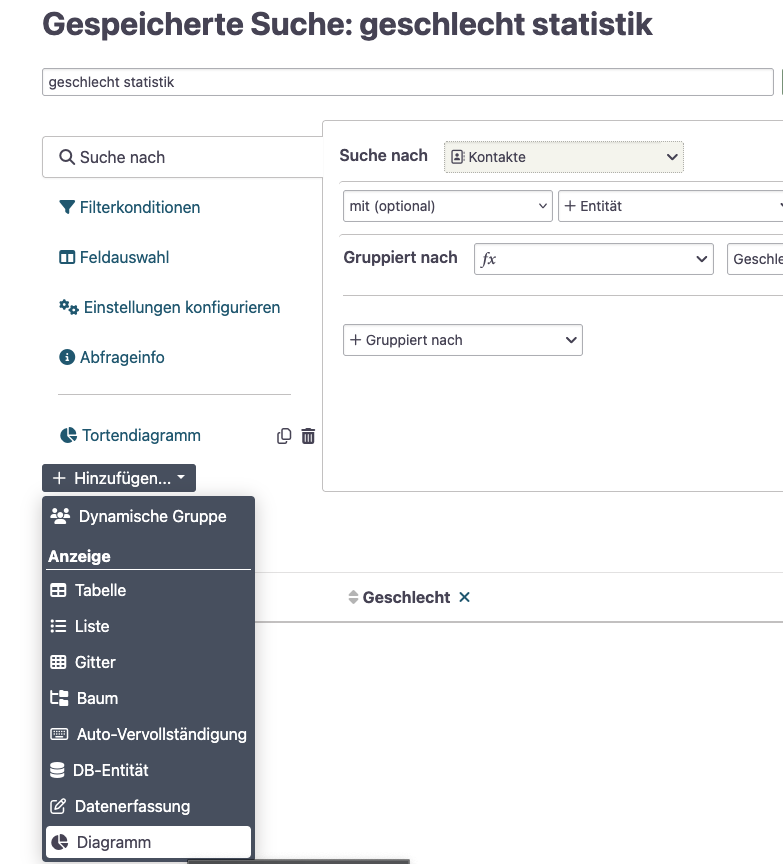

- Legt eine neue Suche in SearchKit an oder bearbeitet eine existierende Suche. Im Visualisierungsschritt habt ihr Zugriff auf die Spalten der Ergebnisse der SearchKit-Suche. Überlegt euch daher schon jetzt, welche Datenpunkte eure Visualisierung benötigt.

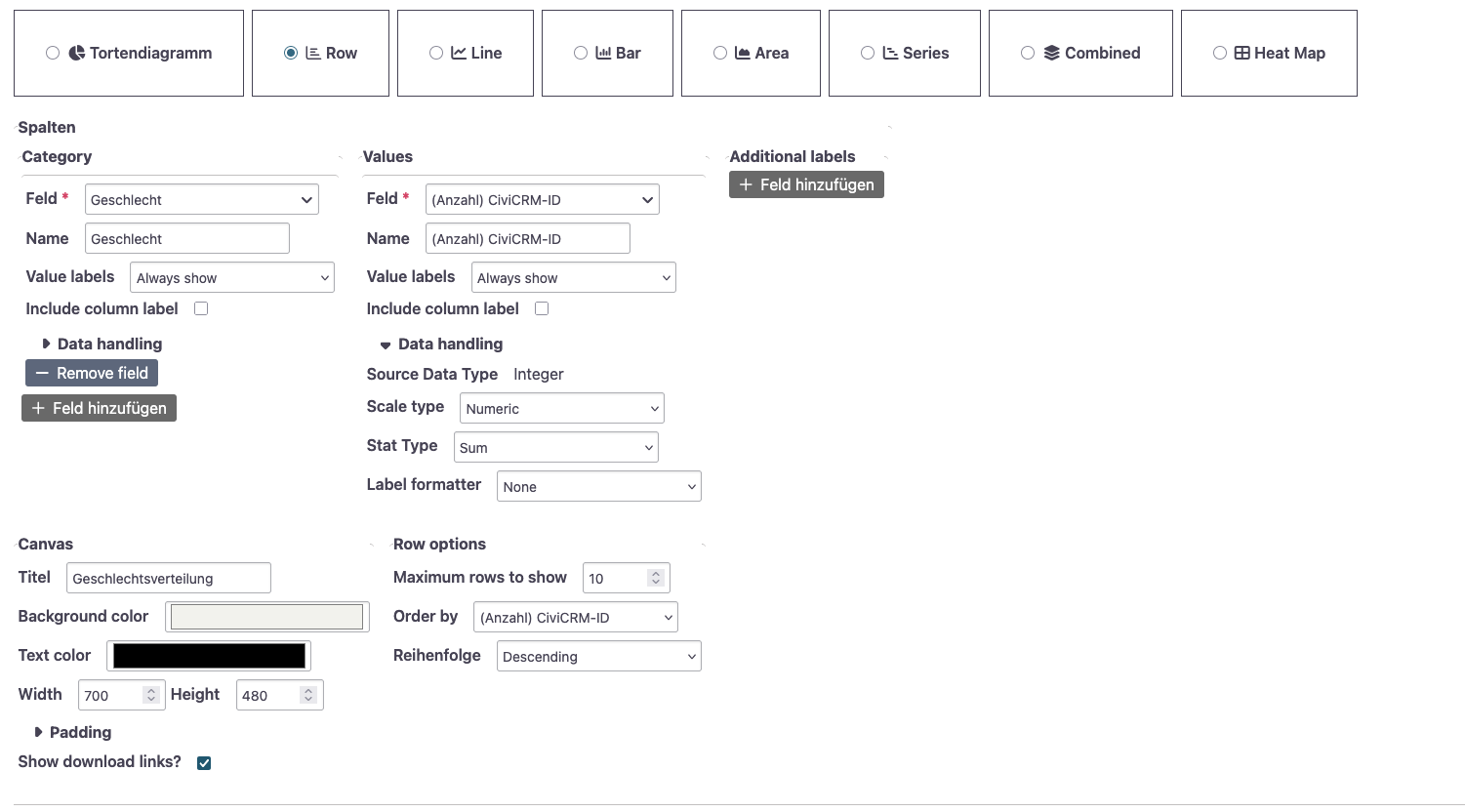

Visualisierung

- im SearchKit Editor links Hinzufügen -> Diagramm

- im ChartKit Editor können verschiedene Visualisierungstypen über ein grafisches User Interface konfiguriert werden. Verwendet werden können die Spalten der Ergebnisse der SearchKit Suche.

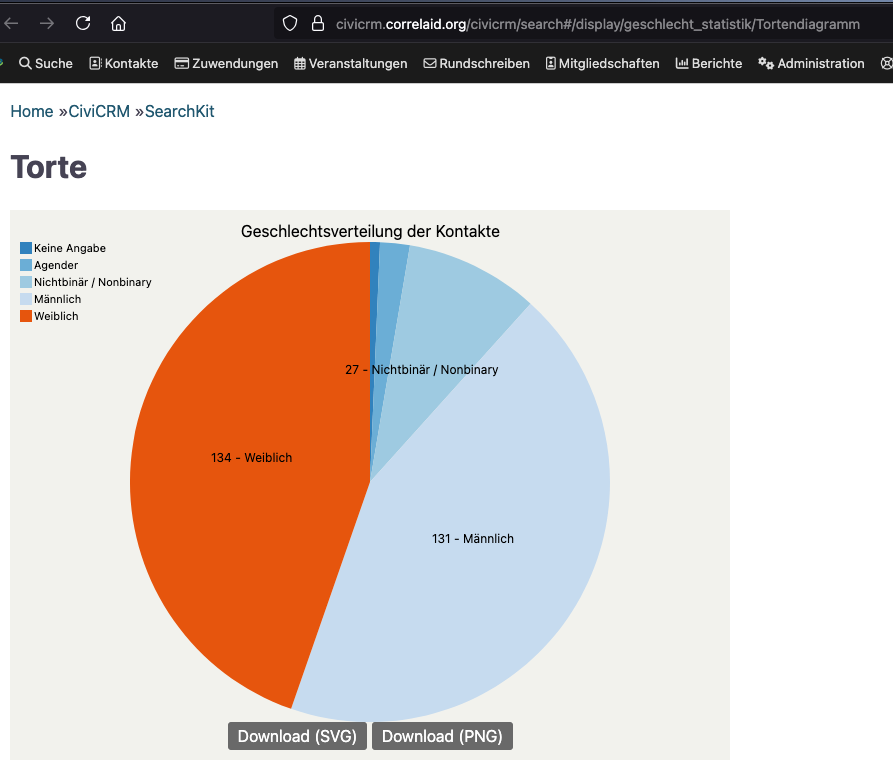

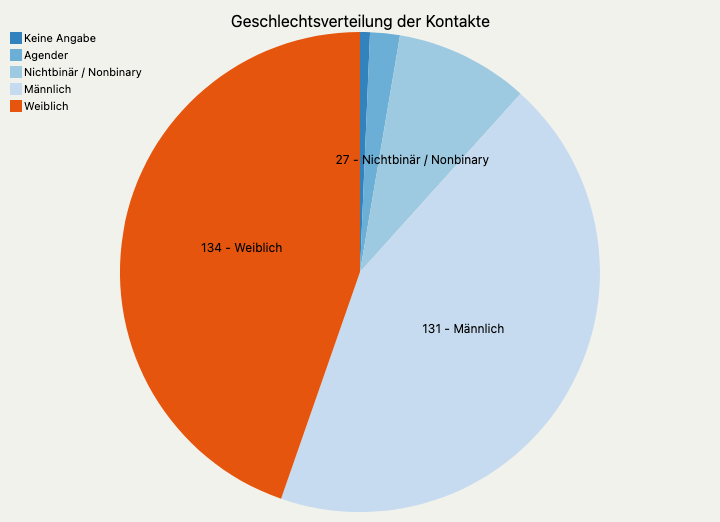

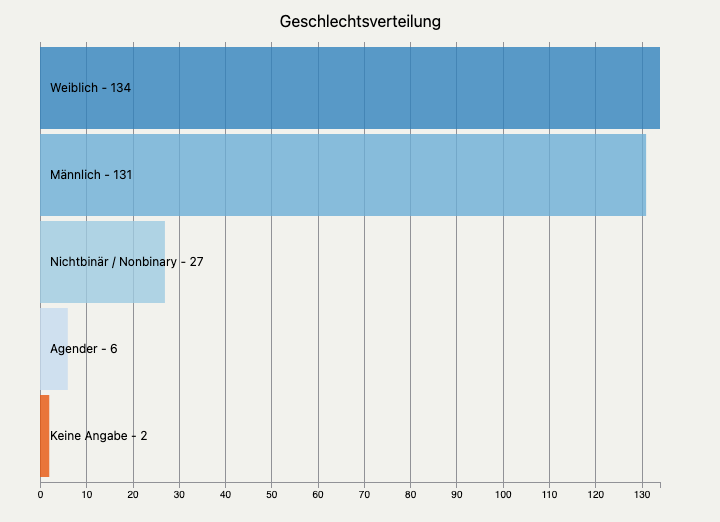

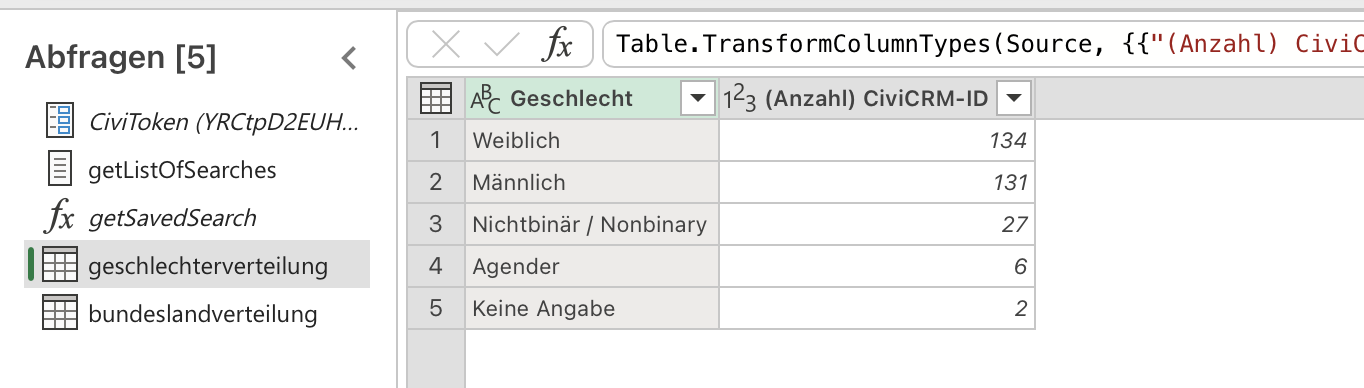

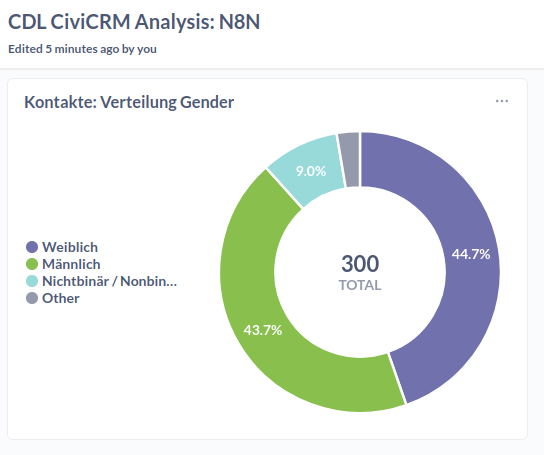

Use Case: Darstellung der Geschlechtsverteilung

Einfache grafische Darstellungen sind hilfreich, um z.B. die Zusammensetzung der eigenen Zielgruppe zu verstehen. Hier machen wir eine einfache Auswertung der Geschlechtsverteilung unserer Kontakte.

Die Tabelle, die aus unserer SearchKit-Suche herauskommt, sieht wie folgt aus:

| Geschlecht | Anzahl CiviCRM-ID |

|---|---|

| Weiblich | 134 |

| Männlich | 131 |

| Nichtbinär / Nonbinary | 27 |

| Agender | 6 |

| Keine Angabe | 2 |

Ihr könnt die Suche bei euch importieren über SearchKit -> Import. Den Code findet ihr hier. Voraussetzung ist, dass die Geschlechtsvariable bei euch gleich benannt sind.

Um die Daten darzustellen, können wir wie oben beschrieben ChartKit nutzen. Hier haben wir zwei Visualisierungen erstellt, ein Torten- und ein Balkendiagramm.

Ihr könnt eure Visualisierungen in CiviCRM im Browser ansehen. Personen, die Zugriff auf die CiviCRM-Suche haben, haben auch Zugriff auf die dazugehörigen ChartKit-Visualisierungen. Es ist nicht möglich, diesen Link mit Externen ohne CiviCRM-Account zu teilen.

Mithilfe der eingebetteten Download-Links könnt ihr sie als PNG- oder SVG-Datei herunterladen.

Fazit

SearchKit und ChartKit ermöglichen in CiviCRM einen unkomplizierten, voraussetzungsniedrigen Setup für Datenanalyse und Visualisierung. ChartKit ist direkt in SearchKit integriert, sodass Visualisierungen direkt bei den dazugehörigen Suchen gespeichert werden. Das bedeutet allerdings, dass ihr eure Visualisierungen nicht anders anordnen oder sortieren könnt, z.B. in einem Dashboard. Auch könnt ihr eure Visualisierungen nicht direkt über Links mit externen Stakeholdern teilen oder zugänglich machen. Dafür ist die Exportfunktion gut zugänglich.

Die Kombination von Search- und ChartKit ist gut geeignet, wenn ihr ausgewählte Visualisierungen direkt in CiviCRM verfügbar haben wollt und diese nur selten und anlassbezogen exportieren müsst. Wenn ihr Darstellungen live mit Externen teilen oder ein Dashboard bauen wollt oder generell höhere Anforderungen an die Gestaltung habt, seid ihr (noch) auf externe Tools angewiesen.

SearchKit & Excel / Google Sheets

Wir laden SearchKit Suchergebnisse über die API in Excel oder Google Sheets. Die Datenvisualisierung und weitere Auswertung machen wir dort.

🧹 daten-organisieren: CiviCRM Datenbank; Power Query bzw. Google Apps Script zur Ansprache der CiviCRM API

🔢 daten-auswerten: SearchKit

📊 daten-visualisieren: Excel bzw. Google Sheets

SearchKit, Excel und Power Query

Voraussetzungen

- CiviCRM API Schlüssel, um auf die folgenden Endpunkte der CiviCRM API eurer Instanz zuzugreifen:

ajax/api4/SavedSearch/getajax/api4/SearchDisplay/download

- Lizenz für Microsoft Excel Desktop Version1, optional für Excel für das Web

Bei diesem Ansatz hinterlegt ihr euren API-Schlüssel in einer Excel-Datei. Alle Personen, die diese Datei öffnen, können somit auf euren API-Schlüssel und somit auf die Daten zugreifen, auf die ihr in CiviCRM Zugriff habt. Seid euch der Risiken bewusst und geht verantwortungsvoll mit entstandenen Dateien um.

Anleitung

A. Setup

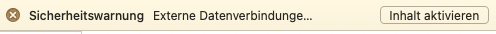

-

Ladet die

test-excel.xlsxDatei aus dem GitHub Repository herunter. Dazu oben rechts auf die drei Punkte und dann auf "Download" bzw. "Herunterladen" klicken. -

Öffnet die Datei in der Desktop Version von Microsoft Excel.

-

Aktiviert die externen Datenverbindungen, indem ihr auf "Inhalt aktivieren" klickt.

-

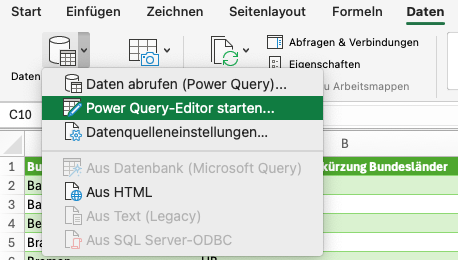

Öffnet den Power Query Editor über den Ribbon Daten -> Daten abfragen (Power Query) -> Power Query-Editor starten.

- In der Seitenleiste links wählt den Eintrag

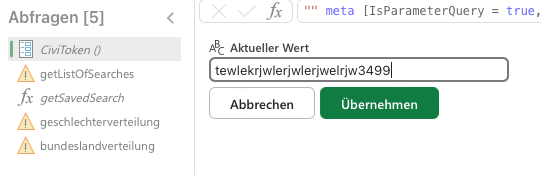

CiviToken. Gebt euren API Schlüssel für die CiviCRM API ein. Klicke auf "Übernehmen".

B. Eigene SearchKit-Suchen herunterladen

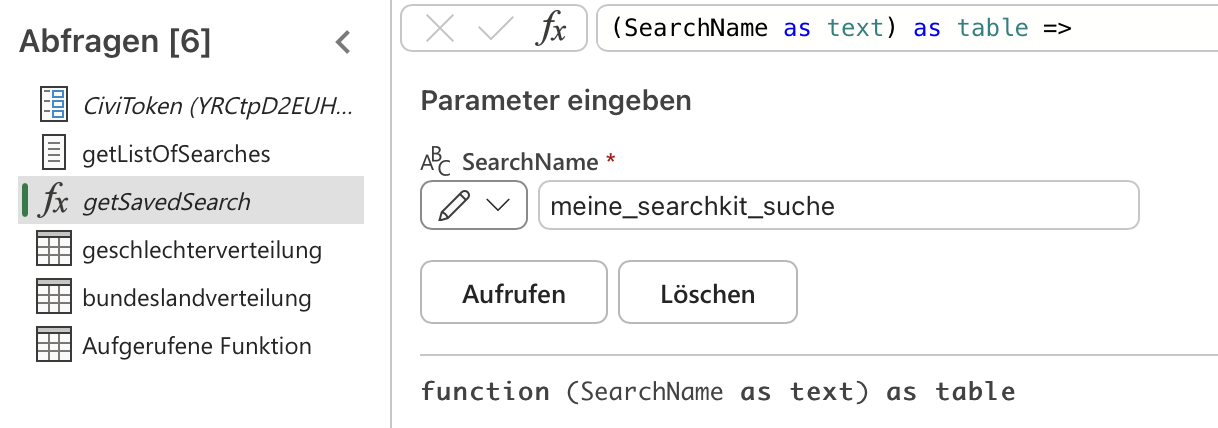

Im Power Query Editor ist die Funktion getSavedSearch (dt. "bekomme gespeicherte Suche") hinterlegt. Mit dieser Funktion könnt ihr eigene SearchKit Suchen abfragen.

-

In der linken Seitenleiste -> fx

getSavedSearch -

in das Feld "SearchName" den Namen eurer SearchKit Suche eingeben. Wichtig: Leerzeichen müsst ihr mit Unterstrichen ersetzen. z.B. wird "geschlecht statistik" zu "geschlecht_statistik" oder "Zuwendungen nach Zahlungsmethode" zu "Zuwendungen_nach_Zahlungsmethode". auf "Aufrufen" klicken.

-

dies legt einen neuen Query in der Seitenleiste an und führt ihn direkt aus. Ihr könnt dem Query mit Rechtsklick einen aussagekräftigeren Namen geben.

-

Wenn ihr ganz normal auf den Query in der Seitenleiste klickt, solltet ihr das Ergebnis eurer SearchKit Suche als Tabelle sehen.

-

Sehr ihr anstatt dessen eine Warnung oder einen Fehler, ist etwas schief gelaufen. Überprüft, ob ihr die richtigen Zugriffsrechte habt und ob ihr den API Schlüssel bei Setup richtig hinterlegt habt.

-

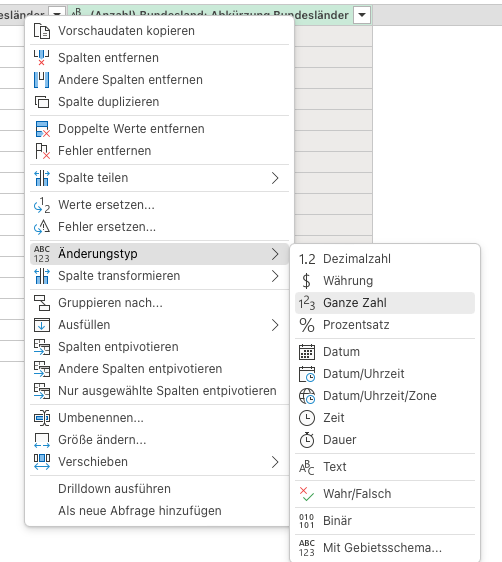

Um in Excel gut weiterarbeiten zu können, müsst ihr noch sicherstellen, dass die Daten den richtigen Typ haben. Das ist v.a. wichtig für Zahlenwerte wie Anzahl, Mittelwert, usw. Hierzu in der Vorschautabelle im Power Query Editor Rechtsklick auf den Spaltennamen -> Änderungstyp. Dann den gewünschten Datentyp auswählen.

- Schließt den Power Query Editor mit dem Button Schließen und Laden. Dies legt ein neues Tabellenblatt für die neuen Queries an und fügt die Ergebnistabellen dort ein.

- Ihr könnt jetzt die Tabelle markieren mit den Daten weiterarbeiten: z.B. ein Diagramm (Einfügen -> Diagramm auswählen) oder eine Pivot-Tabelle (Einfügen -> PivotTable) einfügen.

Tipp: auf Windows könnt ihr noch genauer kontrollieren, wie und wo ihr eure Power Queries verwenden wollt. Auf Youtube gibt es viele Videos zu Power Query, die mit der Windows Version arbeiten und euch zeigen, was ihr noch so machen könnt.

C. Power Queries aktualisieren und bearbeiten

Über Ribbon Daten -> Alle Aktualisieren könnt ihr eure Power-Query-Abfragen aktualisieren. Verbundene Diagramme, Pivot-Tabellen und sonstige Auswertungen aktualisieren sich automatisch.

Falls ihr die Funktion bearbeiten möchtet, könnt ihr dies über Rechtsklick auf getSavedSearch -> Erweiterter Editor tun. Den Code für die Funktion sowie einen Power Query, der euch eine Liste aller SearchKit Suchen zurückgibt, haben wir auch im GitHub Repository hinterlegt.

Power Query wird in Excel für das Web nur eingeschränkt unterstützt. Es gibt keinen Power Query Editor, aber bestehende Queries funktionieren und es gibt den "Alle aktualisieren" Button. Verwendet ihr Excel in der Cloud, kann ein*e Kolleg*in die Queries anlegen und dann die Excel-Datei in die Cloud laden.

Fazit

Die Verwendung von Microsoft Excel und PowerQuery ist vor allem sinnvoll, wenn ihr ...

- a) ... sowieso schon Daten in Excel verwaltet und ihr diese mit Daten aus eurem CiviCRM kombinieren wollt

- b) ... eine unkomplizierte, interne Lösung sucht, um einfache Grafiken und "Dashboards" zu erstellen

Da es sich bei Microsoft um einen US-amerikanischen "Big-Tech" Anbieter handelt, solltet ihr auf Datenschutz und auch -sicherheit achten, vorzugsweise nur aggregierte Daten importieren und generell überlegen, welche Art von Daten ihr "in die Hände von Google" geben wollt, selbst wenn sie nicht mehr unter die DSGVO fallen.

SearchKit, Google Sheets und Google Apps Script

Voraussetzungen

- CiviCRM API Schlüssel, um auf die folgenden Endpunkte der CiviCRM API eurer Instanz zuzugreifen:

ajax/api4/SavedSearch/getajax/api4/SearchDisplay/download

- Google Konto2

Bei diesem Ansatz hinterlegt ihr euren API-Schlüssel in einem Google Apps Script. Alle Personen, die Mitarbeiter-Zugriff (en: Editor) auf das Google Sheet haben, können auf den Apps Script Editor und somit auf euren API-Schlüssel und alle Daten zugreifen, auf die ihr in CiviCRM Zugriff habt. Seid euch der Risiken bewusst und geht verantwortungsvoll mit Zugriffsrechten um.

Anleitung

A. Setup

Schneller Setup

- Erstellt eine Kopie dieses Google Sheets: Datei -> Kopie erstellen.

- Ihr bekommt eine Warnung, dass eine Apps Script-Datei ebenfalls kopiert wird. Ihr könnt den Code erst überprüfen, bevor ihr eine Kopie erstellt.

- Öffnet das erstellte Google Sheet und öffnet die Google Apps Script Konsole über Erweiterungen -> Apps Script. Ein neues Fenster öffnet sich mit der Datei

runAllSearches.gsgeöffnet.

Der Code ist auf zwei .gs-Dateien3 aufgeteilt:

runAllSearches.gs: hier gebt ihr euren API-Schlüssel ein und verwendet die FunktionfetchSavedSearch, um Ergebnisse einer oder mehrerer SearchKit-Suche(n) mithilfe CiviCRM-API in das Google Sheet zu importieren.fetchSavedSearch.gs: enthält die FunktionfetchSavedSearch

Den Code findet ihr auch im GitHub Repository.

Manueller Setup

- Erstellt ein leeres Google Sheet und gebt ihm einen sinnvollen Namen (z.B. "CiviCRM API Test")

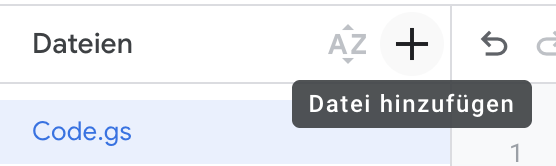

- Öffnet Google Apps Script (Erweiterungen -> Apps Script). Es öffnet sich ein Editor.

- Benennt die Datei

Code.gsum inrunAllSearches(drei Punkte rechts neben Namen -> Umbenennen) und drückt Enter. - Löscht den Beispielcode und kopiert den Code der Datei

runAllSearches.jsin das Editorfenster. Speichert mithilfe vonSTRG/CMD+Soder dem Diskettensymbol. - Erstellt eine neue Script-Datei im Apps Script Editor: + Zeichen bei Datei -> Script

- Löscht den Beispielcode und kopiert den Code der Datei

fetchSavedSearch.jsin das Editorfenster. Speichert mithilfe vonSTRG/CMD+Soder dem Diskettensymbol.

B. Apps Script ausführen & automatisieren

Manuelle Ausführung

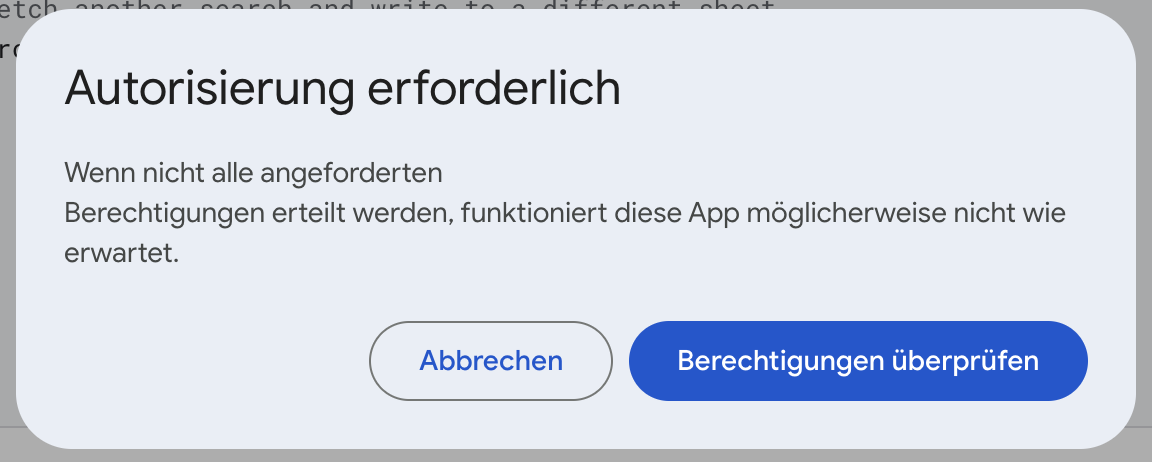

Um den Code laufen zu lassen, drückt ihr auf den Button "Ausführen" (en: "Run") (nicht: "Bereitstellen"!), wenn ihr runAllSearches.gs geöffnet habt. Wenn ihr zum ersten Mal den Code ausführt, werdet ihr dazu aufgefordert, der App Berechtigungen zu geben (mehr dazu im aufklappbaren Infokasten).

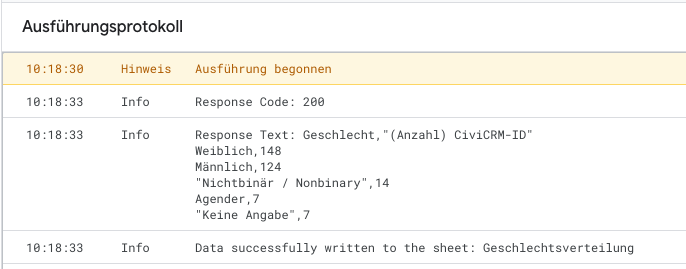

Im Ausführungsprotokoll (en: Execution Log) könnt ihr nachvollziehen, ob die Ausführung funktioniert.

Die Sache mit den Berechtigungen

Die Sache mit den Berechtigungen

Wenn ihr zum ersten Mal den Code ausführt, werdet ihr dazu aufgefordert, der App Berechtigungen zu geben. Dies müsst ihr tun, damit das Skript auf die CiviCRM-API zugreifen kann und die Daten in das Google Sheet schreiben kann. Wenn ihr Google Chrome verwendet, folgen weitere Warnungen, da es sich nicht um eine "verifizierte App" handelt.

Die Berechtigungen gelten nur für eure eigene Kopie der App. Diese habt ihr erstellt, ...

- ... indem ihr das von uns bereitgestellte Google Sheet mit dem dazugehörigen Apps Script Code kopiert habt ("schneller Setup"). Wir haben auf eure Kopie des Google Sheets keinen Zugriff.

- ... indem ihr eine eigenes Google Sheet plus eigenem Apps Script Code erstellt habt ("manueller Setup"). Wir haben auf euer Google Sheet und auch den Code keinen Zugriff.

Trotzdem solltet ihr Code, den ihr von anderen übernehmt, immer sorgfältig prüfen. Hier können euch LLMs oder ein Blick durch Expert*innen weiterhelfen.

Automatisierte Ausführung

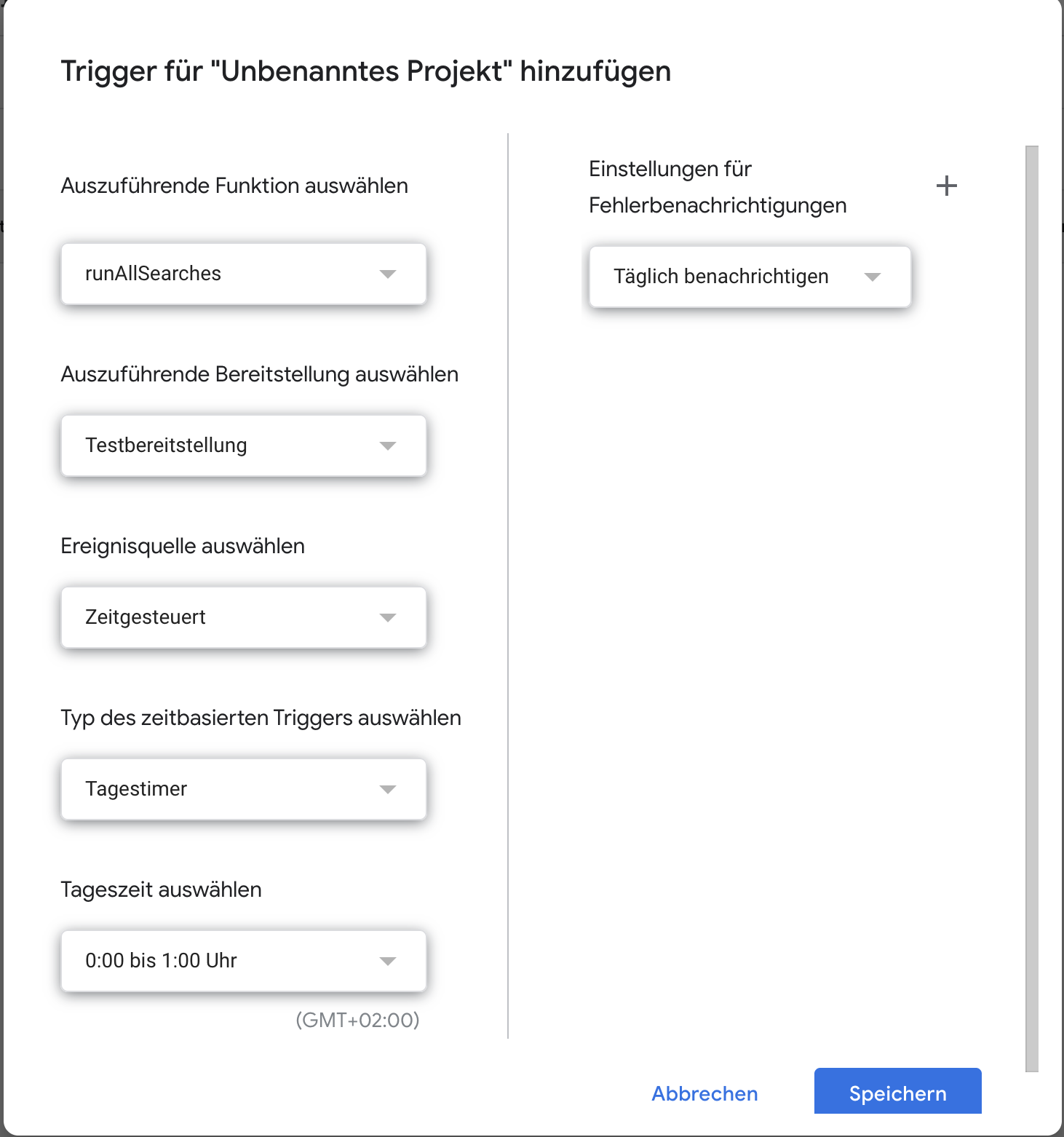

Damit ihr nicht jedes Mal auf "Ausführen" klicken müsst, könnt ihr die Ausführung von runAllSearches.gs auch mithilfe von sogenannten Triggern automatisieren. Trigger lösen die Ausführung des Skripts aus. Es gibt verschiedene Trigger (z.B. beim Öffnen des Google Sheets etc.), eine Übersicht findet ihr hier.

Die genaue Wahl des Triggers hängt von eurer Anwendung ab. Wir empfehlen:

- Zeitgesteuert: Aktualisiert die Daten und damit verknüpften Visualisierungen regelmäßig. Den genauen Rhythmus (stündlich/täglich/wöchentlich) legt ihr fest. Eine populäre Wahl ist einmal pro Tag mit Ausführung in der Nacht (siehe Screenshot).

- beim Öffnen des Google Sheets: Garantiert, dass sich eure Daten und damit verknüpfte Visualisierungen bei jedem Öffnen des Sheets aktualisieren.

Die Einrichtung eines Triggers ist intuitiv über eine grafische Benutzeroberfläche im Google Apps Script Editor möglich. Eine kurze Anleitung findet ihr hier.

C. Eure eigenen Suchen abrufen

Um eure eigenen Suchen abzurufen, müsst ihr den Code im Google Apps Script Editor anpassen.

In der Datei runAllSearches.gs:

- Fügt in Zeile 2 euren API-Schlüssel zwischen den "" ein.

- Fügt in Zeile 10 den Namen eurer SearchKit Suche und den Namen des Tabellenblatts in den Funktionsaufruf von

fetchSavedSearchjeweils zwischen den "" ein. Das Tabellenblatt muss noch nicht existieren, die Funktion erstellt es dann automatisch. - Optional: Wiederholt Schritt 1+2 in Zeile 14, wenn ihr zusätzlich Ergebnisse einer anderen Suche in ein weiteres Tabellenblatt importieren wollt. Falls nicht, löscht den Code in Zeile 14.

- Optional: Wenn ihr noch mehr Suchen importieren wollt, könnt ihr den Code aus Zeile 10 so oft kopieren und anpassen (siehe Schritte 1+2), wie ihr wollt.

function runAllSearches() {

var apiKey = "fügt euren API-SCHLÜSSEL hier ein"; // Replace with your actual API key within the "", e.g. "b2391932kss"

// Dokumentation der fetchSavedSearch Funktion

// fetchSavedSearch(searchName, sheetName, apiKey);

// @param {string} searchName - The name of the saved search in CiviCRM.

// @param {string} sheetName - The name of the sheet in the Google Spreadsheet where data should be written. Does not need to exist when executed

// @param {string} apiKey - Your CiviCRM API key.

fetchSavedSearch("fügt den Namen eurer SearchKit Suche hier ein", "fügt den Namen des Google Sheet Blattes hier ein", apiKey);

//Beispiel: fetchSavedSearch("geschlecht_statistik", "Geschlechtsverteilung", apiKey);

// ihr könnt noch mehr Suchen in anderen Blättern abrufen

fetchSavedSearch("fügt den Namen eurer SearchKit Suche hier ein", "fügt den Namen des Google Sheet Blattes hier ein", apiKey);

//Beispiel: fetchSavedSearch("Bundesland", "Bundeslandverteilung", apiKey);

}

Folgt der Anleitung in B. Apps Script ausführen, um euren angepassten Code auszuführen.

D. Visualisierung

Sobald die Daten in Google Sheets importiert sind, könnt ihr wie gewohnt die Visualisierungstools von Google Sheets verwenden, um Balken-, Tortendiagramme usw. zu erstellen. Auf YouTube und mit der Suchmaschine eurer Wahl findet ihr zahlreiche Ressourcen.

Die Visualisierungen könnt ihr im jeweiligen Tabellenblatt hinzufügen oder in einem eigenen "Dashboard"-Sheet arrangieren (z.B. hier).

Die interaktiven Datenvisualisierungen lassen sich einzeln veröffentlichen und in eine Website einbetten. Hier der Donut-Chart zur Geschlechtsverteilung, den ihr auch im Sheet "Dashboard" unseres Google Sheets findet:

Google Sheets als Datenquelle für andere Visualisierungstools

Google Sheets als Datenquelle für andere Visualisierungstools

Einige Tools zur Datenvisualisierung können Google Sheets als Datenquelle verwenden (z.B. DataWrapper oder Canva). Anstelle die Visualisierungen direkt in Google Sheets zu erstellen, könnt ihr Google Sheets auch nur als "automatisiert aktualisierten Zwischenspeicher" verwenden. Achtet hierbei auf Datensicherheit - manchmal müsst ihr euer Google Sheet (teilweise) publizieren.

Fazit

Die Verwendung von Google Sheets und Google Apps Script ist vor allem sinnvoll, wenn ihr ...

- a) ... sowieso schon Daten in Google Sheets verwaltet und ihr diese mit Daten aus eurem CiviCRM kombinieren wollt

- b) ... eine unkomplizierte, interne Lösung sucht, um einfache Grafiken und "Dashboards" zu erstellen

- c) ... einen "Zwischenspeicher" für andere Anwendungen benötigt, die Google Sheets als Datenquelle verwenden können

Da es sich bei Google um einen US-amerikanischen "Big-Tech" Anbieter handelt, solltet ihr auf Datenschutz und auch -sicherheit achten, vorzugsweise nur aggregierte Daten importieren und generell überlegen, welche Art von Daten ihr "in die Hände von Google" geben wollt, selbst wenn sie nicht mehr unter die DSGVO fallen.

-

Für die Einrichtung und Konfiguration ist die Desktop Version von Excel notwendig. Das Abrufen der Daten funktioniert dann auch unter Excel für das Web, wenn man die Datei hochgeladen hat. Der Ansatz wurde getestet unter Microsoft Excel for Mac, Version 16.100.3 unter der Lizenz Microsoft 365. ↩

-

Wir haben den Ansatz mit einem Google Account getestet aus unserem Google Workspace for Nonprofits. Theoretisch sollte es aber auch mit einem kostenlosen, privaten Google Account funktionieren. ↩

-

gssteht für Google Apps Script. Technisch gesehen ist Google Apps Script eine Version von JavaScript. ↩

CiviCRM Datenbank & Metabase

Wir verbinden das Business Intelligence Tool Metabase mit der CiviCRM Datenbank und verwenden es, um Daten auszuwerten und zu visualisieren.

🧹 daten-organisieren: CiviCRM Datenbank und (partiell) in Metabase, direkte Anbindung der CiviCRM Datenbank an Metabase

🔢 daten-auswerten: Metabase

📊 daten-visualisieren: Metabase

Voraussetzungen

- Direkter Zugriff auf eure CiviCRM Datenbank

- Einen Account für eine Metabase Instanz mit Admin-Rechten

Anleitung

A. Setup

Fügt wie hier beschrieben eine Verbindung zu eurer Datenbank zu Metabase hinzu.

B. Daten analysieren und visualisieren

Sobald Metabase Zugriff auf eure CiviCRM-Datenbank habt, könnt ihr Fragen erstellen und diese in Dashboards visualisieren und darstellen. Mehr zur Analyse und Visualisierung in Metabase hier.

C. Daten organisieren

Die CiviCRM-Datenbank hat sehr viele Tabellen - verständlich bei so einer umfassenden Softwarelösung. Zum Beispiel sind in der Tabelle Kontakte nur numerische IDs für das Geschlecht vorhanden. Die Labels finden sich in einer eigenen Tabelle. Diese Tabellen bei jeder Frage zusammenzuführen, ist auf Dauer nervig und zeitraubend. Es lohnt es sich daher, ein bisschen Datenmodellierung in Metabase zu machen. Hierfür könnt ihr die Modell-Funktion verwenden. So könnt ihr z.B. ein Modell “Kontakte” anlegen, welches die Genderoptionen bereits an die Kontakte-Tabelle anfügt. Euer Modell könnt ihr dann in allen weiteren Fragen und verbundenen Analyse- und Visualisierungsschritten nutzen.

Use Case: Kontakt- und Spendendashboard

Als Teil des Datenvorhabens haben wir ein Dashboard erstellt, welches einen Überblick über die Kontakte und Spenden + Kampagnenbeiträge in unserer Testdatenbank gibt. Das Dashboard hat zwei Tabs:

- Kontakte: Deskriptive Statistiken zu unseren Fake-Kontakten

- Spenden: Deskriptive Statistiken zu Zuwendungen, spezifisch zu Spenden und Kampagnenbeiträgen.

Als kleiner Vorgeschmack hier die Visualisierung unserer fiktiven Spendenkampagne im Dezember 2024:

Vorteile

- Über die Datenbank erhaltet ihr Zugriff auf den gesamten Umfang eurer Daten und seid somit sehr flexibel in euren Auswertungen

- Tools wie BI-Tools funktionieren am besten mit einer direkten Verbindung mit der CiviCRM-Datenbank

Nachteile

- Datensicherheit: ein direkter Zugriff auf die Datenbank ist auch immer ein Datensicherheitsrisiko. Deshalb kann euer CiviCRM-Dienstleister (berechtigte) Bedenken haben, euch diesen Zugriff zu gewähren. Greift wenn möglich auf die API zurück.

- Komplexität: Die Daten liegen in der CiviCRM in zahlreichen Tabellen ab. Sich hier zurecht zu finden, erfordert eine Einarbeitung in SQL und einen gewissen Spürsinn: Die Entity-Relationship-Diagramme (ERDs) für CiviCRM sind zwar hier dokumentiert, aber trotzdem müsst ihr euch sicher zu einem gewissen Grad selbst durch die Daten "wühlen", v.a. wenn ihr Daten aus verschiedenen CiviCRM-Datentypen kombinieren wollt.

Fazit

Für die Verwendung von bestimmten externen Tools (v.a. BI-Tools) kann ein direkter Zugriff auf die CiviCRM-Datenbank sinnvoll sein. Aufgrund der Datensicherheitsrisiken solltet ihr sehr verantwortungsbewusst mit dieser Option umgehen und Rücksprache mit eurem CiviCRM-Dienstleister halten.

Falls ihr für externe Tools den Zugriff auf eine Datenbank benötigt, ist alternativ das Duplizieren eines Teils der CiviCRM Daten in eine Managed Datenbank über die API und Workflow-Tools eine Option. Siehe dafür das Kapitel zu ETL.

ETL: CiviCRM API, Automation, Managed DB & Metabase

flowchart TB

subgraph CiviCRM

API[API]

end

subgraph ETL[Automation Tool Knoten]

Extract[Daten extrahieren]

Transform[Daten transformieren]

Load[Daten in die DB laden]

Extract --> Transform --> Load

end

ExtDB[(Managed DB)]

Metabase[Metabase]

ETL -->|Modellierung in API-Explorer| API

ETL --> ExtDB

Metabase --> ExtDB

In diesem Unterkapitel werden Tool-Kombinationen vorgestellt, mit denen sich ETL-Prozesse (Extract, Transform & Load) umsetzen lassen. Über eine API extrahieren wir Daten aus CiviCRM, um sie dann zu verarbeiten und schließlich in eine externe Datenbank zu laden.

Die externe Datenbank dient als Data Warehouse. Die Prozesse werden ausgeführt von einem Workflow Automation Tool, das hier für Data Orchestration eingesetzt wird. Zusätzlich schließen wir Metabase an die externe Datenbank an, um die Daten visualisieren zu können.

Zum einen ist der Betrieb von CiviCRM abhängig von einer Datenbank (Anwendungsdatenbank). Wenn wir nun Anfragen auf dieser Datenbank laufen lassen, könnte das für Nutzer:innen zu längeren Wartezeiten oder gar Ausfällen führen. Zum anderen ist der Sinn von einem klassischen Data Warehouse Daten aus verschiedenen Quellen für Analyse modelliert und transformiert zu speichern, was bei der Anwendungsdatenbank nicht unbedingt der Fall sein muss. Außerdem haben Data Warehouses andere Betriebsanforderungen.

ETL & Relational Data Warehouse

ETL & Relational Data Warehouse

Die vorgestellten Ansätze sind eine reduzierte Form von ETL und unterscheiden sich in verschiedenen Hinsichten von üblichen Vorgehensweisen. Die wichtigsten Transformationsschritte die wir durchführen, werden über die API abgebildet. Oft wird dafür ein spezielles Tool wie dbt genutzt.

Unsere managed Datenbank, die selbst relational ist, nutzen wir als Relational Data Warehouse. Dies bedeutet, das wir die Daten in einer bestimmten strukturierten Form speichern und abfragen können. Alternativen dazu sind Warehouse-Architekturen wie Data Lakes, wo Daten in weniger strukturierter Form gespeichert werden.

Eine gute Erklärung dieser Begriffe findet ihr in diesem Video.

Dieser ETL-Ansatz wird anhand von zwei Use Cases veranschaulicht, bei denen jeweils eines der zwei ausgewählten Workflow Automation Tools verwendet wird. Zuerst erklären wir, wie man mit n8n durch das Duplizieren eines Datenausschnitts die Datengrundlage für die Visualisierung einfacher deskriptive Statistiken schaffen kann.

Danach wird der komplexere Use-Case der Visualisierung von Spender:innenwanderungen thematisiert. Nachdem notwendige Daten über einen API-Request aggregiert wurden, geschieht dies mithilfe von Kestra.

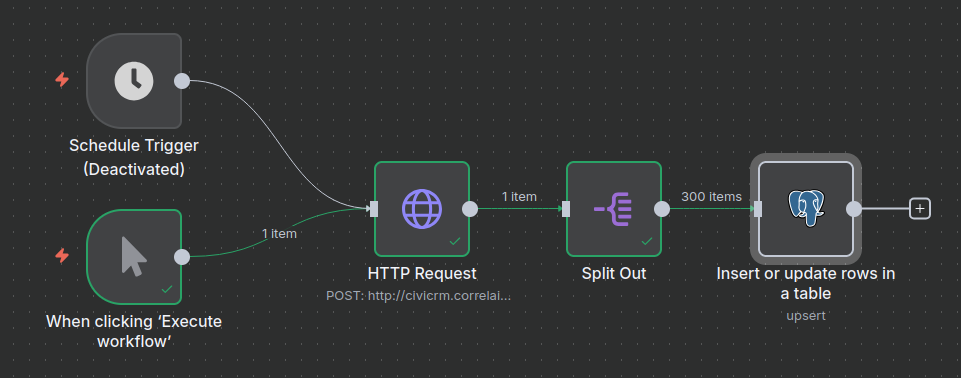

Basic ETL mit n8n - Einfache deskriptive Statistiken

Wir orchestrieren einen ETL-Prozess (Extract, Transform & Load) mit n8n um die Frage zu beantworten, wie sich Gender unter den in CiviCRM erfassten Kontakten verteilt und wollen dies mit einen Donut-Chart visualisieren.

🧹 daten-organisieren: CiviCRM API Explorer & Neon; CiviCRM API & n8n

🔢 daten-auswerten: Metabase

📊 daten-visualisieren: Metabase

Voraussetzungen

- Account bei Neon

- API-Token für eine CiviCRM-Instanz

- n8n-Instanz oder ein Abonnement des n8n SaaS

- Metabase-Instanz oder ein Abonnement des Metabase SaaS

Anleitung

Dieser Ansatz besteht aus vier Komponenten, die wir nacheinander vorbereiten.

A: Anlegen einer Tabelle in der Managed Datenbank (Neon)

Option 1: GUI

Erstelle eine neue Tabelle (wie hier beschrieben)

- Gebe der Tabelle den Namen

kontakte - Füge die Spalten

civicrm-idundgenderhinzu - Wähle für

civicrm-idden Datentypintegerund die contraintsNot null, sowieUniqueaus - Wähle für

genderden Datentypvarcharund den contraintsNot nullaus

Constraints

Constraints

Constraints sind Regeln, die die Datenintegrität und -konsistenz gewährleisten, indem sie festlegen, welche Daten wie in Tabellen gespeichert werden dürfen. Sie dienen als Datenvalidierungsprüfungen auf Ebene der Datenbank.

Option 2: SQL-Editor

Die Tabelle lässt sich im SQL-Editor von Neon durch das Ausführen des folgenden Codes erstellen:

CREATE TABLE "kontakte" (

"id" integer PRIMARY KEY GENERATED ALWAYS AS IDENTITY (sequence name "kontakte_id_seq"),

"civicrm_id" integer NOT NULL UNIQUE,

"gender" varchar

);

Diesen und anderen SQL-Code findet ihr auch im Repository in dem Ordner supporting_code/sql.

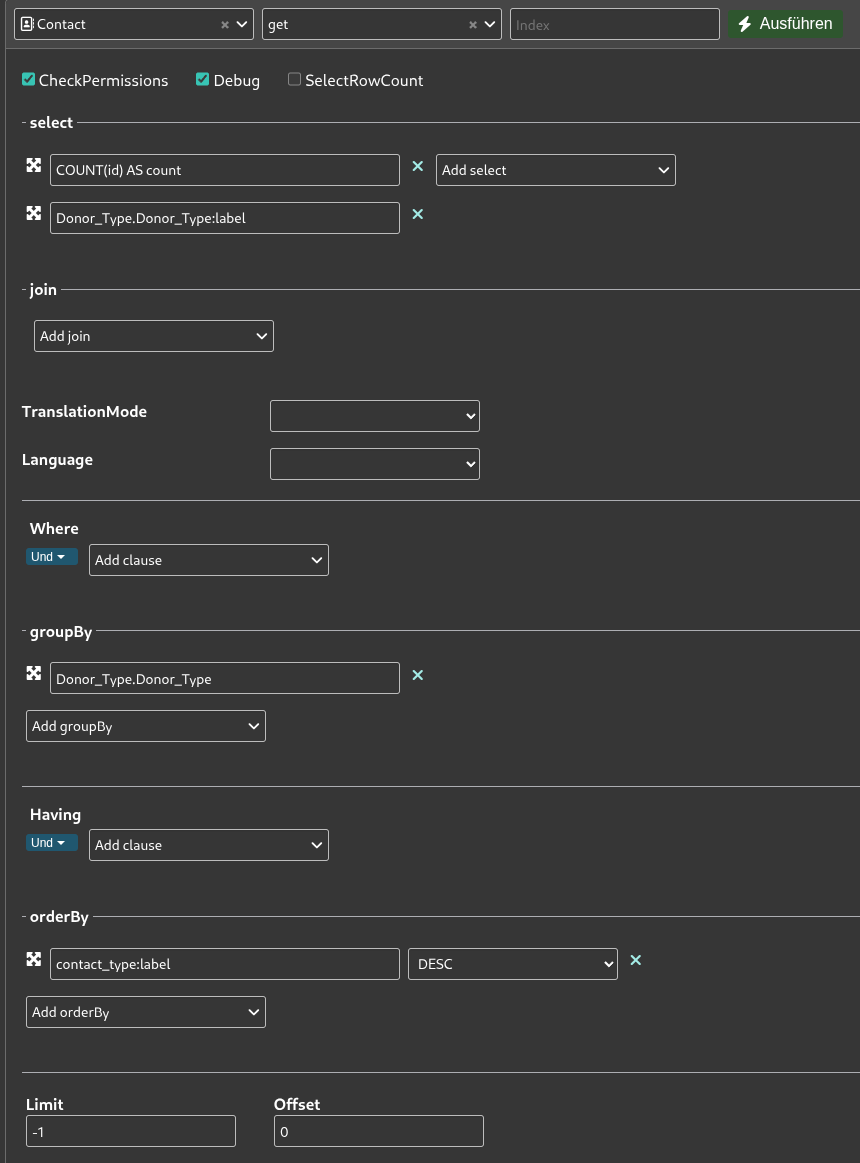

B: Datenmodellierung im API-Explorer von CiviCRM

Navigiert zum API Explorer und wählt als Entität Contact, sowie als Aktion get aus. Unter select, wählt gender_id:label und id aus. Wichtig ist, dass ihr außerdem -1 bei limit setzt, um alle Daten zu erhalten. Bei diesem Use Case beschränkt sich die Datenmodellierung auf die Feldauswahl.

Tabellen in CiviCRM

Tabellen in CiviCRM

gender ist eine separate Tabelle, die alle auf dieser CiviCRM-Instanz auswählbaren Gender enthält. Kontakte haben ein Feld mit dem Namen gender_id, das die ID einer Reihe in der Gender-Tabelle enthält, die zum Beispiel als Spalte Label hat.

Nach diesen Schritten könnt ihr bereits den Request Body weiter unten unter REST kopieren. Dies sollte entsprechen:

params=%7B%22select%22%3A%5B%22gender_id%3Alabel%22%2C%22id%22%5D%7D

C: Anlegen des Flows in n8n

Erstellt einen neuen Workflow auf eurer n8n-Instanz. Am Ende sollte dieser so aussehen:

Den Flow als importierbare Datei findet ihr auch im Repository in dem Ordner supporting_code/n8n_flows

Als Trigger dient sowohl die manuelle Ausführung als auch eine Schedule (regelmäßig terminiertes Ausführen). Letzteres kann zum Beispiel einmal am Tag geschehen.

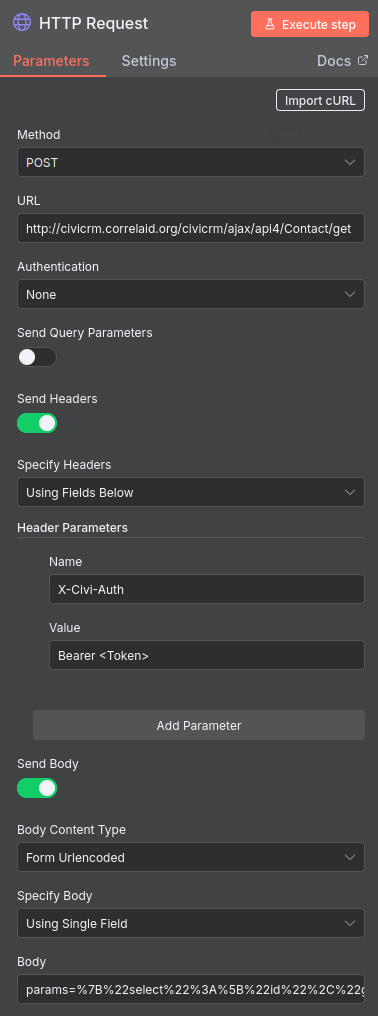

D: Knoten für die API-Anfrage anlegen

Der erste richtige Knoten enthält die API-Anfrage. Unten seht ihr, wie ihr ihn konfigurieren müsst.

-

Fügt unter URL am Anfang die URL eurer Instanz ein. Im API Explorer unter dem Reiter REST ist dies auch als Variable

CRM_URLdefiniert. -

Fügt euer API-Token an der Stelle ein, wo im Screenshot <Token> steht.

-

Im Feld Body, das bei Setzen der oben angezeigten Optionen erscheint, fügt ihr nun den im API-Explorer generierten Body ein (siehe oben).

-

Ihr könnt nun eure Angaben direkt mit einem Klick auf Execute Workflow testen.

Viele Daten?

Viele Daten?

Wenn ihr mehr als wenige hundert Kontakte in CiviCRM habt, oder viele Datenfelder verarbeiten wollt, solltet ihr nicht alle Daten auf einmal anfragen, sondern mit Pagination arbeiten. Dies lässt sich im API-Explorer konfigurieren und in n8n so berücksichtigen.

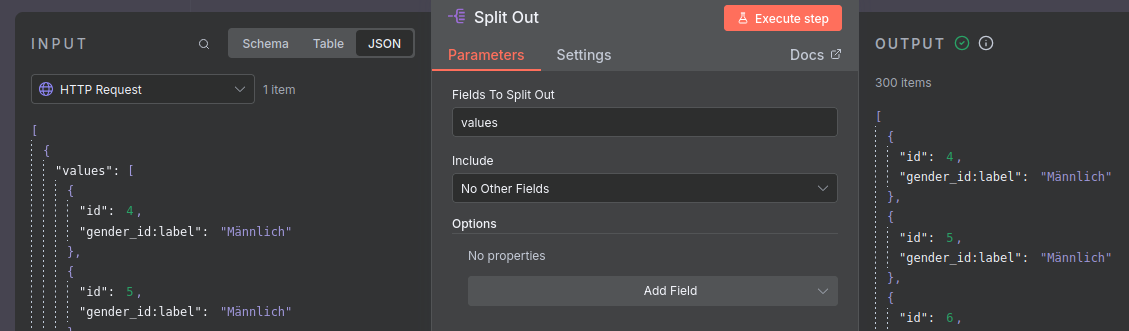

E: Knoten für die Separation von Zeilen anlegen

Der Output des vorherigen Knotens ist standardmäßig ein json Objekt, das die Daten als Liste als Wert des keys values enthält. Der Knoten-Typ Split Out ermöglicht es uns, diese Liste, bzw. deren Einträge zu isolieren.

Die Konfiguration dieses Knotens ist simpel: füllt das Feld Values to Split Out einfach mit dem Wert values.

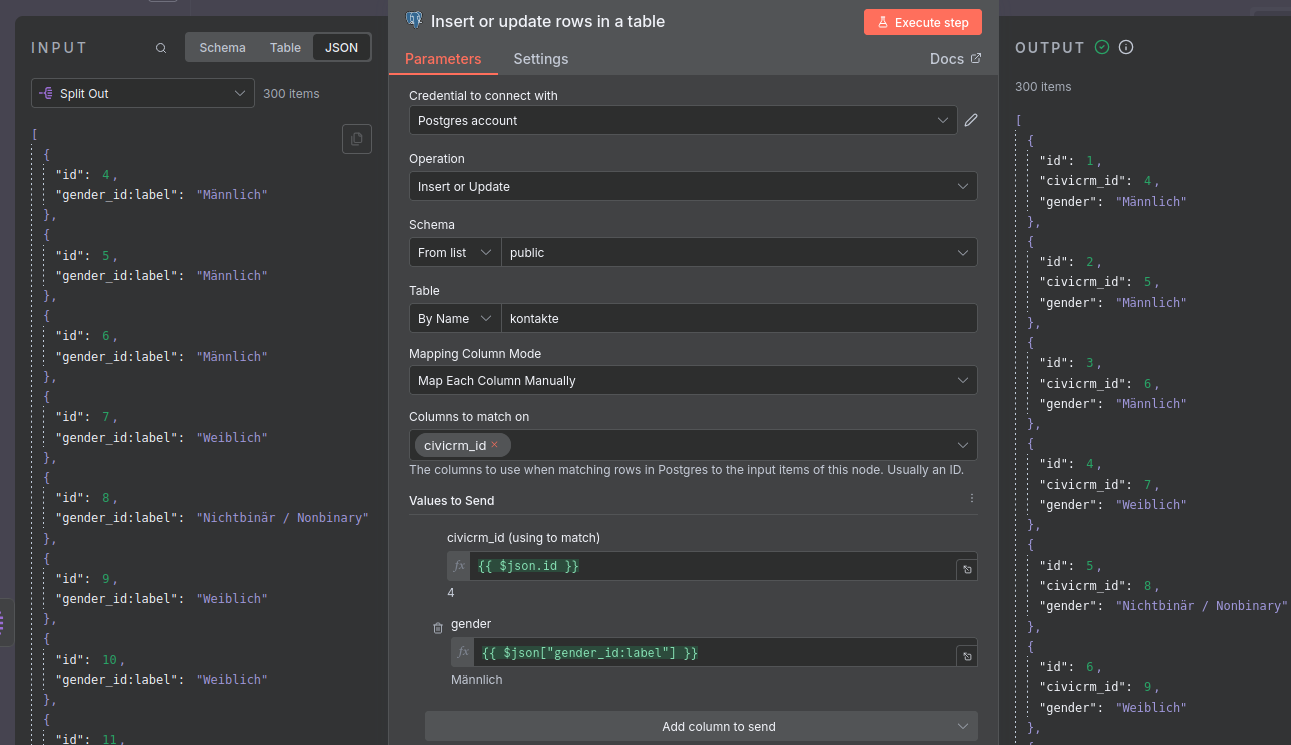

F: Knoten für das Laden der Daten in die managed Datenbank anlegen

Dieser letzte Knoten ist für das Laden der Daten in die managed Datenbank auf Neon, unser Data Warehouse, zuständig.

-

Legt zunächst ein Credential für Postgres an. Wie dies funktioniert, ist hier beschrieben. Die notwendigen Informationen findet ihr in der Neon Konsole.

-

Wenn ihr dies erledigt habt, nutzt den Knoten-Typ für Postgres: Insert or update rows in a table und konfiguriert ihn so wie im Bild unten.

Bei der Zuordnung der Felder aus der API zu den Spalten der Tabelle ist wichtig, dass es einen Unterschied zwischen id und civicrm_id gibt. Ersteres wird automatisch durch die Datenbank erstellt, zweiteres erlaubt Updates von bereits vorhanden Kontakten durch die Referenz dieser. So wird sichergestellt, dass bei erneutem Laden der Daten keine Duplikate entstehen, sondern vorhandene Reihen geupdatet werden.

Full Load

Full Load

In den Begriffen des Data Engineering vollziehen wir hier einen regelmäßigen Full Load. Eine alternative wäre ein ressourcensparender Incremental Load, bei dem nur neue Daten geladen werden. Neu könnte mit Bezug auf Kontakte solche meinen, die geupdatet oder tatsächlich neu hinzugekommen sind.

Das Anlegen von Incremental Loads kann jedoch komplex werden, weil sie Informationen wie das Datum eines Updates und die zuverlässige Sortierung von Ergebnissen der Items einer API-Anfrage voraussetzen.

G: Visualisierung in Metabase

-

Verbindet wie hier beschrieben die Datenbank mit Metabase. An die notwendigen Informationen kommt ihr ähnlich wie beim Anlegen der Postgres Credentials für den letzten Knoten des Workflows.

-

Lest euch den Abschnitt zu Visualisierung in Metabase durch. Die obige Visualisierung ist ein Pie-Chart, für den die Daten mit der Summarize Funktion verarbeitet wurden, indem die Reihen pro Gender gezählt wurden.

Fazit

Mit dem vorgestellten Tool-Setup lässt sich der Use Case ohne Code umsetzen, in dem viel Komplexität abstrahiert und versteckt wird. Für simple Use Cases reicht das obige Setup aus. Die Funktionalitäten von n8n sind für anspruchsvollere Data Orchestration jedoch begrenzt.

Ein wesentlicher Nachteil ist die deutlich langsamere Iteration beim Debugging: Workflows müssen komplett durchlaufen werden, Zwischenschritte sind schwer inspizierbar, und es fehlen Debugging-Tools wie Breakpoints oder detaillierte Logs. Zudem ist das Setup weniger transparent als code-basierte Lösungen – Versionskontrolle via Git, Code Reviews und Knowledge Transfer sind schwieriger, da Tool-spezifisches Wissen erforderlich ist. Die Flexibilität ist eingeschränkt, wenn komplexe Transformationslogik benötigt wird, die über die verfügbaren Nodes hinausgeht. Schließlich entsteht ein Vendor Lock-in: Eine Migration zu anderen Tools ist aufwendig, und man ist abhängig von der Weiterentwicklung der eingesetzten Produkte.

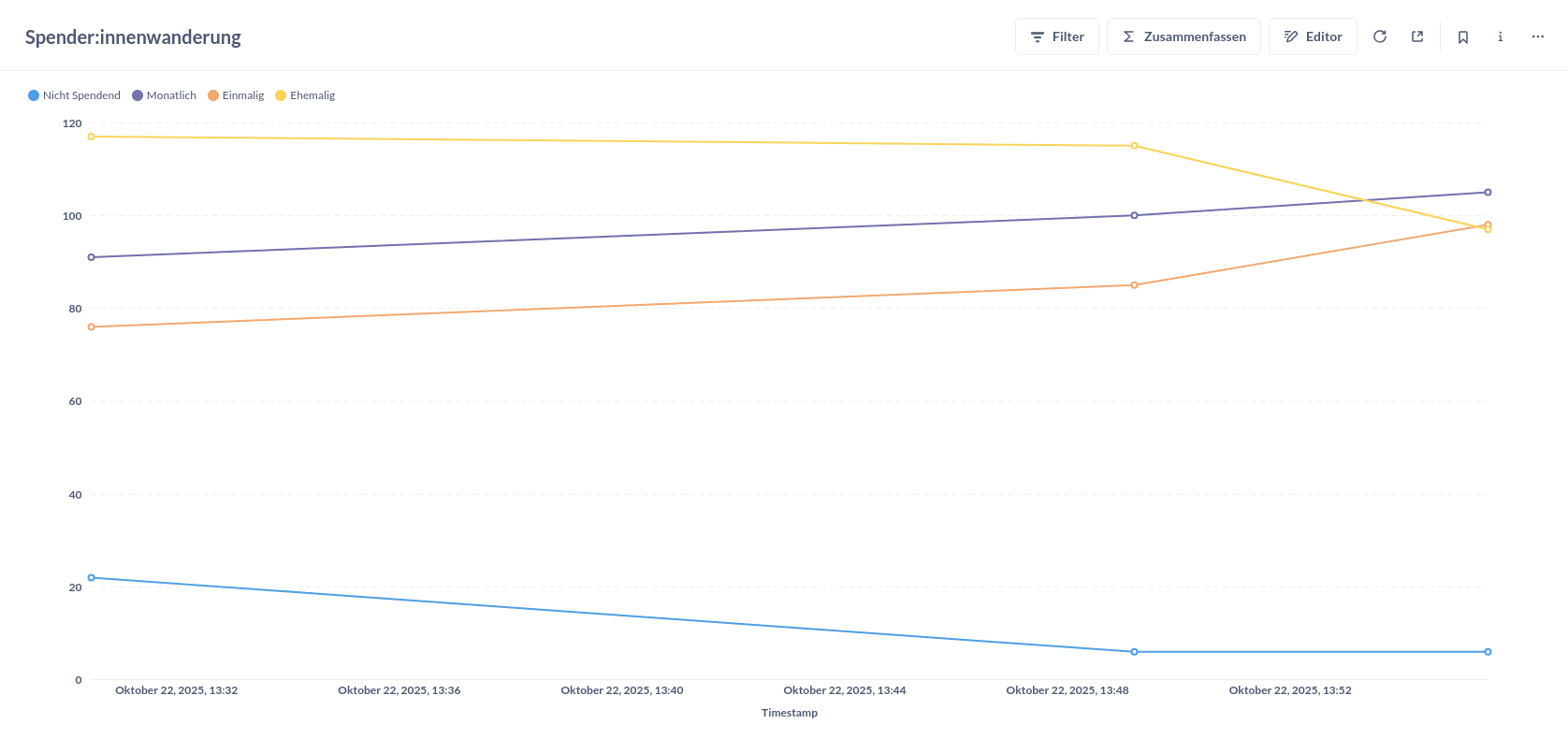

ETL mit Kestra - Spender:innenwanderungen über die Zeit

Wir orchestrieren einen ETL-Prozess (Extract, Transform & Load) mit Kestra um die Frage zu beantworten, wie sich Spender:innentypen über die Zeit entwickeln. Dazu aggregieren wir Daten über die CiviCRM API und laden sie täglich in eine Datenbank, um die Entwicklung mit einem Line-Chart zu visualisieren.

🧹 daten-organisieren: CiviCRM API Explorer & Neon; CiviCRM API & Kestra

🔢 daten-auswerten: Metabase

📊 daten-visualisieren: Metabase

Voraussetzungen

- Account bei Neon

- API-Token für eine CiviCRM-Instanz

- Kestra-Instanz oder ein Abonnement des Kestra SaaS

- Metabase-Instanz oder ein Abonnement des Metabase SaaS

- Benutzerdefiniertes Datenfeld Donor Type in CiviCRM

Anleitung

Dieser Ansatz besteht aus 5 Komponenten , die wir nacheinander vorbereiten.

A: Erweiterung der CiviCRM Datenfelder

Wie hier beschrieben, benötigen wir ein neues benutzerdefiniertes Datenfeld, das den Typ einer spendenden Person erfasst. Für Demonstrationszwecke halten wir es simpel und legen das Feld Donor Type als Auswahlliste mit den Optionen One Time Donor, Monthly Donor und Past Donor an. Die Benennung ist dabei beliebig veränderbar und es könnten auch mehr Optionen genutzt werden.

Für unseren Test erstellen wir programmatisch Testdaten mit diesem Datenfeld. In der Realität müsst ihr dieses neue Feld jedoch in eure Erfassung von Kontakten integrieren, oder die Information anderweitig erfassen. Eine Option ist zum Beispiel die Nutzung von Gruppen für Kontakte. Auf Englisch ist dies hier dokumentiert. Ihr könntet Gruppen mit Kriterien wie ist zu einer Contribution zugeordnet anlegen.

B: Anlegen einer Tabelle in der Managed Datenbank (Neon)

Option 1: GUI

Erstelle eine neue Tabelle (wie hier beschrieben):

- Gebe der Tabelle den Namen

spendende_typen_agg - Füge die Spalte

timestampmit dem Datentyptimestampund dem ConstraintNot nullhinzu - Füge für jeden Spender:innentyp eine Spalte hinzu (z.B.

nicht_spendend,einmalig,monatlich,ehemalig) - Wähle für diese Spalten den Datentyp

integerund den ConstraintNot nullaus

Constraints

Constraints

Constraints sind Regeln, die die Datenintegrität und -konsistenz gewährleisten, indem sie festlegen, welche Daten wie in Tabellen gespeichert werden dürfen. Sie dienen als Datenvalidierungsprüfungen auf Ebene der Datenbank.

Option 2: SQL-Editor

Die Tabelle lässt sich im SQL-Editor von Neon durch das Ausführen des folgenden Codes erstellen:

CREATE TABLE IF NOT EXISTS "spendende_typen_agg" (

"id" integer PRIMARY KEY GENERATED ALWAYS AS IDENTITY (

sequence name "spendende_typen_agg_id_seq"

),

"timestamp" timestamp NOT NULL,

"nicht_spendend" integer NOT NULL,

"monatlich" integer NOT NULL,

"einmalig" integer NOT NULL,

"ehemalig" integer NOT NULL

);

Diesen und anderen SQL-Code findet ihr auch im Repository in dem Ordner supporting_code/sql.

C: Datenmodellierung im API-Explorer von CiviCRM

Navigiert zum API Explorer und wählt als Entität Contact, sowie als Aktion get aus. Hier besteht die Datenmodellierung nun aus einer Aggregation nach dem Typ der spendenden Person.

Konfiguriert die API-Anfrage so wie in dem Screenshot oben:

- Wählt unter select die Felder

COUNT(id) AS countundDonor_Type.Donor_Type:labelaus - Nutzt die groupBy Funktion, um die Reihen nach

Donor_Type.Donor_Typezu gruppieren - Sortiert die Ergebnisse unter orderBy nach

contact_type:labelin absteigender Reihenfolge (DESC)

Nach diesen Schritten könnt ihr bereits den Request Body weiter unten unter REST kopieren. Dies sollte in etwa so aussehen:

params=%7B%22select%22%3A%5B%22COUNT%28id%29%20AS%20count%22%2C%22Donor_Type.Donor_Type%3Alabel%22%5D%2C%22orderBy%22%3A%7B%22contact_type%3Alabel%22%3A%22DESC%22%7D%2C%22groupBy%22%3A%5B%22Donor_Type.Donor_Type%22%5D%7D

D: Anlegen des Flows in Kestra

Erstellt einen neuen Workflow auf eurer Kestra-Instanz. Der vollständige Flow als YAML:

id: civicrm_donor_type_count_warehouse

namespace: company.team

tasks:

- id: request

type: io.kestra.plugin.core.http.Request

uri: "{{ secret('CIVICRM_API_URI') }}"

headers:

X-Civi-Auth: "Bearer {{ secret('CIVICRM_API_TOKEN') }}"

method: POST

contentType: application/x-www-form-urlencoded

body: |

params=%7B%22select%22%3A%5B%22COUNT%28id%29%20AS%20count%22%2C%22Donor_Type.Donor_Type%3Alabel%22%5D%2C%22orderBy%22%3A%7B%22contact_type%3Alabel%22%3A%22DESC%22%7D%2C%22groupBy%22%3A%5B%22Donor_Type.Donor_Type%22%5D%7D

- id: to_rows

type: io.kestra.plugin.transform.jsonata.TransformValue

from: "{{ outputs.request.body }}"

expression: |

[{

"nicht_spendend": $sum(values[$."Donor_Type.Donor_Type:label" = null].count),

"ehemalig": $sum(values[$."Donor_Type.Donor_Type:label" = "Past Donor"].count),

"monatlich": $sum(values[$."Donor_Type.Donor_Type:label" = "Monthly Donor"].count),

"einmalig": $sum(values[$."Donor_Type.Donor_Type:label" = "One Time Donor"].count)

}]

- id: insert_agg

type: io.kestra.plugin.jdbc.postgresql.Query

url: "jdbc:postgresql://{{ secret('CIVICRM_NEON_WAREHOUSE_HOST') }}:5432/main"

username: "{{ secret('CIVICRM_NEON_WAREHOUSE_USER') }}"

password: "{{ secret('CIVICRM_NEON_WAREHOUSE_PW') }}"

sql: |

INSERT INTO spendende_typen_agg(timestamp, nicht_spendend, ehemalig, monatlich, einmalig)

SELECT NOW(), nicht_spendend, ehemalig, monatlich, einmalig

FROM jsonb_to_recordset('{{ outputs.to_rows.value }}'::jsonb)

AS t(nicht_spendend int, ehemalig int, monatlich int, einmalig int);

fetchType: NONE

triggers:

- id: schedule

type: io.kestra.plugin.core.trigger.Schedule

cron: 0 0 * * 0

Diesen und andere Kestra-Flows findet ihr auch im Repository in dem Ordner supporting_code/kestra_flows

1. Knoten für die API-Anfrage

Der erste Knoten enthält die API-Anfrage:

- Fügt unter

uriam Anfang die URL eurer Instanz ein. Im API Explorer unter dem Reiter REST ist dies auch als VariableCRM_URLdefiniert - Fügt euer API-Token als Secret ein (siehe oben)

- Im Feld

bodyfügt ihr den im API-Explorer generierten Body ein (siehe oben)

Ein Beispiel-Output der API-Anfrage ist:

{

"values": [

{"count": 22, "Donor_Type.Donor_Type:label": null},

{"count": 76, "Donor_Type.Donor_Type:label": "One Time Donor"},

{"count": 117, "Donor_Type.Donor_Type:label": "Past Donor"},

{"count": 91, "Donor_Type.Donor_Type:label": "Monthly Donor"}

],

"entity": "Contact",

"action": "get",

"debug": null,

"version": 4,

"count": 4,

"countFetched": 4

}

2. Knoten für die Verarbeitung mit JSONata

JSONata ist eine Sprache für die Abfrage und Verarbeitung von JSON-Daten. In diesem Fall transformieren wir die API-Antwort in ein Format, das sich direkt in unsere Datenbank-Tabelle einfügen lässt.

Der JSONata-Knoten nutzt die Expression:

[{

"nicht_spendend": $sum(values[$."Donor_Type.Donor_Type:label" = null].count),

"ehemalig": $sum(values[$."Donor_Type.Donor_Type:label" = "Past Donor"].count),

"monatlich": $sum(values[$."Donor_Type.Donor_Type:label" = "Monthly Donor"].count),

"einmalig": $sum(values[$."Donor_Type.Donor_Type:label" = "One Time Donor"].count)

}]

So funktioniert die Expression:

- Filtern:

values[$."Donor_Type.Donor_Type:label" = "Past Donor"]durchsucht das Arrayvaluesund filtert nur die Objekte, deren Label dem gesuchten Typ entspricht - Extrahieren:

.countgreift auf dascount-Feld der gefilterten Objekte zu - Aggregieren:

$sum()summiert alle gefundenen Werte (relevant wenn mehrere Matches existieren) - Strukturieren: Die eckigen Klammern

[]erstellen ein Array mit einem einzelnen Objekt, dessen Keys (nicht_spendend,ehemalig, etc.) den Spaltennamen in unserer Datenbank entsprechen

Beispiel-Output:

{ "ehemalig": 117, "einmalig": 76, "monatlich": 91, "nicht_spendend": 22 }

3. Knoten für das Laden der Daten in die Managed Datenbank

Dieser letzte Knoten ist für das Laden der Daten in die Managed Datenbank auf Neon, unser Data Warehouse, zuständig:

- Legt zunächst ein Secret für Postgres an. Die notwendigen Informationen findet ihr in der Neon Konsole

- Konfiguriert den Knoten so, dass die transformierten Daten als neue Zeile mit dem aktuellen Timestamp in die Tabelle

spendende_typen_aggeingefügt werden

Wenn ihr Kestra selbst hostet, könnt ihr API Tokens etc. als Secrets über Environment Variables anlegen.

Die SQL-Query im Detail:

INSERT INTO spendende_typen_agg(timestamp, nicht_spendend, ehemalig, monatlich, einmalig)

SELECT NOW(), nicht_spendend, ehemalig, monatlich, einmalig

FROM jsonb_to_recordset('{{ outputs.to_rows.value }}'::jsonb)

AS t(nicht_spendend int, ehemalig int, monatlich int, einmalig int);

So funktioniert die Query:

INSERT INTO spendende_typen_agg(...): Definiert in welche Tabelle und Spalten die Daten eingefügt werdenNOW(): Erzeugt den aktuellen Timestamp für die Zeile, sodass wir später nachvollziehen können, wann diese Daten erfasst wurdenjsonb_to_recordset(...): Konvertiert das JSON-Objekt aus dem vorherigen Knoten in eine relationale Tabellenstruktur'{{ outputs.to_rows.value }}': Kestra-Syntax um auf den Output desto_rows-Knotens zuzugreifenAS t(nicht_spendend int, ...): Definiert das Schema der temporären Tabelletmit den entsprechenden Spaltentypen

Regelmäßige Snapshots

Regelmäßige Snapshots

In den Begriffen des Data Engineering vollziehen wir hier regelmäßige Snapshots. Bei jeder Ausführung wird eine neue Zeile mit den aktuellen Zählungen der verschiedenen Spender:innentypen angelegt. So können wir die Entwicklung über die Zeit nachvollziehen.

H: Visualisierung in Metabase

-

Verbindet wie hier beschrieben die Datenbank mit Metabase. An die notwendigen Informationen kommt ihr ähnlich wie beim Anlegen der Postgres Credentials für den letzten Knoten des Workflows

-

Lest euch den Abschnitt zu Visualisierung in Metabase durch. Die Visualisierung ist ein Line-Chart, der die Entwicklung der verschiedenen Spender:innentypen mit jeweils einer Linie über die Zeit darstellt. Nutzt die Spalte

timestampfür die X-Achse und die verschiedenen Typen-Spalten für die Y-Achse

Fazit

Es lässt sich ein ähnliches Fazit wie für den Abschnitt zu ETL mit n8n ziehen. Ein Unterschied ist die Erforderniss der Erweiterung der CiviCRM-Datenfelder, um das Informationen zu Spender:innen zu erfassen.

Kestra als Workflow Tool benötigt im Vergleich zu n8n deutlich mehr technische Skills. Ein wesentlicher Vorteil ist die Versionierbarkeit: Flows werden als YAML-Dateien definiert und können in Git-Repositories gespeichert werden, was Code Reviews, Knowledge Transfer und Zusammenarbeit im Team erheblich erleichtert. Zudem bietet Kestra deutlich mehr Flexibilität – die Code-Umgebung ist erweiterbar, und es stehen umfangreiche Transformationsmöglichkeiten zur Verfügung.

Tools

- CiviCRM-interne Tools

- Excel, Google Sheets & Co. 🔢📊💬🧹

- Business Intelligence Tools🔢📊💬

- Managed Datenbank🧹

- Workflow Automation Tools🔢🧹

- Python & R🔢📊💬🧹

- Self-Hosting

Legende

🧹 daten-organisieren

🔢 daten-auswerten

📊 daten-visualisieren

💬 daten-kommunizieren

(siehe auch Datenlebenszyklus)

CiviCRM-interne Tools

Es lässt sich wiederholen: CiviCRM ist primär ein CRM, kein Datenanalyse- oder Visualisierungstool. Da jedoch externe Tools für mehr Komplexität und Aufwand sorgen, haben wir uns auch mit den Möglichkeiten von CiviCRM selbst beschäftigt.

Unsere Experimente haben wir mit unserer selbst gehosteten Basisinstallation von CiviCRM 6.4.0. durchgeführt. Zwischen der Standalone-Version von CiviCRM und dessen Nutzung in Kombination mit CMS wie Drupal oder Wordpress gibt es Unterschiede. Auch Spezifika von Hosting-Anbietern (z.B. Systopia-eigene Extensions) konnten wir nicht berücksichtigen.

Erweiterung der Datengrundlage

Um Daten auf eine bestimmte Fragestellung hin zu analysieren, benötigt man zunächst dafür geeignete Daten. CiviCRM bietet eine vernünftige Auswahl an Standard-Feldern für die unterschiedlichen Datenklassen (Kontakte etc.). Man kann diese jedoch um Eingabefelder erweitern, sollte man zusätzliche Informationen benötigen.

Tags

Eine einfache Art, Kontakte in Bezug auf Art der Unterstützung zu visualisieren ist, ihnen Tags zuzuordnen. Tags lassen sich in den Einstellungen von CiviCRM erstellen und dann bei der Erstellung von Kontakten setzen. Es lassen sich außerdem Gruppen von Überkategorien festlegen. So kann man als Überkategorie z.B. “Donor Type” erstellen und als dieser Kategorie zugeordnet “One Time Donor”, “Monthly Donor” und “Past Donor”. Die Benennung der Tags ist dabei beliebig. Es ist wichtig, beim Erstellen der Tags die Überkategorie auf nicht auswählbar zu setzen. Beim Import von Kontakten lassen sich nur alle in einem Importierungsvorgang enthaltenen Kontakte zusammen taggen.

Benutzerdefinierte Felder

Eine andere Art CiviCRM Erfassungsmöglichkeiten zu erweitern ist das Anlegen von benutzerdefinierten Feldern. Hierfür muss man zunächst eine Gruppe anlegen und dann ein Feld hinzufügen. In der CiviCRM Dokumentation ist dies hier erklärt.

CiviCRM-Datenbank

Hinter CiviCRM als Software liegt eine relationale SQL-Datenbank1, in der die Daten in zahlreichen Tabellen gespeichert sind. So sind Daten in CiviCRM bereits sehr gut organisiert und verwaltet. Der Zugriff auf die SQL-Datenbank ermöglicht einen direkten Zugriff auf die Daten in CiviCRM. Dies ist v.a. nützlich für andere Komponenten, die einen dauerhaften und beständigen Datenzugriff benötigen.

-

Eine Erklärung des Begriffs “Datenbank” gibt es im Selbstlernmaterial des Civic Data Labs. Relevant für das Verständnis von CiviCRM auch der Abschnitt “Mehr zu Datenbanken”. ↩

CiviCRM-API & API-Explorer

CiviCRM API

CiviCRM hat eine Programmierschnittstelle (Application Programming Interface / API1), welche wir verwenden, um von extern auf CiviCRM-Daten zuzugreifen.

CiviCRM has a stable, comprehensive API (Application Programming Interface) for accessing and managing data. The API is the recommended way for any extension or external program to interact with CiviCRM. CiviCRM also uses its own API to power all new UIs and bundled extensions.2

In der Basisinstallation gibt es für jeden Datentyp in CiviCRM eine sogenannte Entität (en: Entity):

- Kontakte ->

Contact - Aktivitäten ->

Activity - Veranstaltungen ->

Event - Zuwendungen ->

Contribution - Emails ->

Email - uvm.

Jede Entität hat wiederum sogenannte Aktionen, die man mithilfe der API auf ihr ausführen kann. Zum Beispiel kann man Kontakte erstellen (create) oder löschen (delete). Für den Datenzugriff am relevantesten ist die Aktion get, mithilfe der man Dateneinträge abfragen kann.

Aus der Kombination von Entität und Aktion ergeben sich die API-Endpunkte. Hier sind Endpunkte, die wir im Rahmen unserer Experimente verwendet haben:

- Liste von Kontakten:

https://civicrm.correlaid.org/civicrm/ajax/api4/Contact/get - Liste von in SearchKit abgespeicherten Suchen:

https://civicrm.correlaid.org/civicrm/ajax/api4/SavedSearch/get - Die Ergebnisse einer gespeicherten SearchKit Suche herunterladen:

https://civicrm.correlaid.org/civicrm/ajax/api4/SearchDisplay/download

Um Zugriff auf die API zu erhalten, kontaktiert am besten euren CiviCRM-Dienstleister. Wenn ihr CiviCRM selbst hostet und administriert, folgt der Dokumentation.

Anleitungen

API einrichten

Die Konfiguration der API und die Einrichtung von API-Schlüsseln in CiviCRM ist etwas ungewöhnlich und erfordert mehrere Schritte:

- Erweiterung installieren: Zuerst muss die Erweiterung für API-Schlüssel installiert werden. Diese ist unter folgendem Link verfügbar: https://civicrm.correlaid.org/civicrm/admin/extensions?action=update&id=com.cividesk.apikey&key=com.cividesk.apikey

- API-Schlüssel erstellen: Anschließend muss ein API-Schlüssel für einen bestimmten Kontakt erstellt werden.

- Kontakt zu einer Gruppe hinzufügen: Der Kontakt, für den der Schlüssel erstellt wurde, muss einer Gruppe hinzugefügt werden (z. B. der Gruppe „Administratoren“).

- REST-Authentifizierung konfigurieren: Abschließend muss die REST-Authentifizierung konfiguriert werden. Dies erfolgt über den folgenden Link: https://civicrm.correlaid.org/civicrm/admin/setting/authx?reset=1 . Dort müssen die „Authentication Guards“ entfernt und die API-Schlüssel-Methode als erforderliche Authentifizierungsmethode für die relevanten Felder hinzugefügt werden.

API Explorer

🧹 daten-organisieren 🔢 daten-auswerten

Da die Dokumentation der CiviCRM API für Nicht-PHP-Entwickler*innen nicht besonders zugänglich ist, fanden wir es hilfreich, mit dem API-Explorer zu arbeiten. Im API-Explorer kann man mithilfe einer grafischen Benutzeroberfläche direkt in CiviCRM Abfragen an die API konfigurieren und ausprobieren. Das erleichtert es enorm, ...

- ... die richtigen Endpunkte zu finden

- ... zu sehen, wie der

bodybei POST-Requests übergeben wird (siehe unten) - ... die Anfrage so anzupassen, dass sie die gewünschten Daten liefert

Wenn ihr selbst mit der API arbeiten möchtet, ist der API-Explorer ein gutes Werkzeug, um euch in der Entwicklung eurer Lösung zu unterstützen.

In der Basisinstallation findet ihr den API-Explorer unter Unterstützung -> Entwickler -> API-Explorer. Sonst fragt euren CiviCRM-Hosting-Dienstleister.

Anleitungen

POST-Request-Parameter aus dem API-Explorer nutzen

Bei POST-Requests an die CiviCRM API kann ein einzelnes Feld namens params verwendet werden , das eine URL-encoded JSON-Zeichenkette der API-Parameter enthält. URL-Encoding wandelt Sonderzeichen in ein Format um, das sicher in URLs und Formulardaten übertragen werden kann (z.B. wird { zu %7B). Dies ermöglicht es, komplexe JSON-Strukturen als einzelnes Formularfeld im POST-Body zu senden, das CiviCRM dann dekodiert und als API-Parameter verarbeitet.

Wenn man im API-Explorer eine API-Anfrage konfiguriert hat, hier als Beispiel die Übergabe aller Kontakte, lässt sich weiter unten auf der Seite des API-Explorers der Reiter "REST" auswählen. Hier wird dann für unser Beispiel angezeigt:

curl -X POST -H "$CRM_AUTH" "$CRM_URL" \^

-d 'params=%7B%22limit%22%3A25%7D'

Nützlich für API-Anfragen mit anderen Tools ist der folgende Teil des Codes: params=%7B%22limit%22%3A25%7D. Beachtet, dass die Anführungszeichen nicht mitkopiert werden sollten.

-

Eine Erklärung des Begriffs "API" gibt es im Selbstlernmaterial des Civic Data Labs. Es gibt eine API-Dokumentation (Englisch), die einen guten Überblick gibt über die API v4. Allerdings ist die Dokumentation sehr auf PHP ausgerichtet und bei weitem nicht alle Routen + Endpunkte sind dort dokumentiert. ↩

CiviCRM SearchKit & ChartKit

SearchKit und ChartKit sind direkt in CiviCRM integrierte Tools für die Auswertung und Visualisierung von CiviCRM-Daten.

SearchKit

CiviCRM SearchKit ist eine Erweiterung für CiviCRM, die es Nutzer*innen ermöglicht, komplexe Abfragen an ihre Daten zu stellen. Als Nutzer*in kann man filtern, aggregieren, Felder auswählen und gruppieren.

Um sich mit SearchKit vertraut zu machen, empfiehlt es sich, mit einfachen Auswertungen (z.B. "Zählen" von Kontakten nach Kategorie) zu starten und das Komplexitätslevel nach und nach zu starten.

Eine (englischsprachige) Einführung in SearchKit findet sich in der CiviCRM Dokumentation. Auf dem YouTube-Channel von CiviCRM gibt es eine Playlist zu SearchKit.

Vorteile

- mächtiges Analysewerkzeug: ihr könnt verschiedene CiviCRM-Datentypen kombinieren, Einträge filtern, relevante Felder auswählen und Kennzahlen wie Anzahl, Mittelwerte, etc. (aggregiert) ausrechnen

- Zugriff auf Ergebnisse über die API: Ihr könnt Daten in SearchKit aggregieren und über die API in andere Tools einbinden. So habt ihr immer die aktuellen Ergebnisse eurer SearchKit-Suchen verfügbar und könnt mit ihnen weiterarbeiten.

Nachteile

- Das Arbeiten mit SearchKit erfordert eine Einarbeitung in datenorientiertes Denken. SearchKit orientiert sich stark an Konzepten von SQL1, was für Personen, die sich nicht damit auskennen, erst einmal herausfordernd sein kann.

- Das User Interface ist nicht immer intuitiv.

- Bestimmte Transformationen (z.B. Pivotieren) sind nicht möglich.

Fazit

SearchKit erfordert etwas Einarbeitung, aber dann ist es eine gute und mächtige Option um innerhalb von CiviCRM Daten (deskriptiv) auszuwerten. Die Option, die Ergebnisse über die API abzurufen, eröffnet einen vielversprechenden Lösungsraum insb. für einfache deskriptive Auswertungen wie Output-Monitoring etc., in dem Daten in CiviCRM ausgewertet und aggregiert werden und in einem externen Tool visualisiert werden. Bei datenschutzsensibler und verantwortungsbewusster Aggregation der Daten in SearchKit können dann ggf. auch Tools von US-Anbietern zur Weiterverarbeitung verwendet werden, ohne den Datenschutz zu kompromittieren.

ChartKit

Mit ChartKit kann man basierend auf SearchKit-Suchen einfache Grafiken wie Balken-, Linien- oder Tortendiagramme erstellen. Konzeptionell sind ChartKit-Visualisierungen eine weitere Möglichkeit, Ergebnisse von SearchKit-Suchen darzustellen ("Search Display"). Für jede Suche können mehrere Visualisierungen erstellt werden.

Um euch mit ChartKit vertraut zu machen, könnt ihr anhand einer einfachen Suche verschiedene Visualisierungen erstellen.

ChartKit sollte bei neueren Versionen von CiviCRM vorinstalliert sein. Sonst wendet euch an euren Hosting-Dienstleister.

Vorteile

- ChartKit ist direkt in SearchKit integriert und Visualisierungen sind direkt in CiviCRM gespeichert

- grafische Benutzeroberfläche ist relativ verständlich

- ausreichende Auswahl an Visualisierungen

- ein Button zum Download als PNG oder SVG kann hinzugefügt werden -> praktisch

- wird aktiv weiterentwickelt (z.B. Talk beim CiviCamp Hamburg 2024)

Nachteile

- man kann nicht alle Aspekte der Visualisierungen anpassen (z.B. Farben, bestimmte Marker, ...)

- Visualisierungen können nicht über einen Link mit Externen geteilt, in eine Website eingebettet oder über die API abgerufen werden.

- Visualisierungen sind "Anhängsel" von SearchKit Suchen und können nicht anders sortiert oder angeordnet werden.

Fazit

ChartKit ist eine gute Option, wenn ihr Datenvisualisierungen v.a. für den internen Gebrauch oder für Berichte ohne große Design-Anforderungen nutzen möchtet. Der Export-Button direkt in der Visualisierung ist sehr praktisch. Es bestehen (noch) Einschränkungen bei der Verfeinerung der Visualisierungen sowie bei der Teilbarkeit aus CiviCRM hinaus. Wenn ihr ansprechendere oder komplexere Visualiserungen oder Dashboard-Funktionalitäten benötigt, solltet ihr daher auf externe Tools zurückgreifen.

-

Eine Erklärung des Begriffs "SQL" gibt es im Selbstlernmaterial des Civic Data Labs. ↩

Reports/Berichte und Dashlets

Diese Seite wurde von ChatGPT erstellt und redaktionell und inhaltlich überarbeitet und erweitert.

CiviCRM Reports sind vorgefertigte oder individuell erstellbare Auswertungen, mit denen ihr eure Daten aus CiviCRM (z. B. Kontakte, Spenden, Mitgliedschaften, Events) analysieren könnt. Berichte bieten Filter- und Gruppierungsoptionen und können gespeichert, exportiert und auch automatisiert per E-Mail verschickt werden.

CiviCRM-Dashlets sind kleine Dashboardmodule (Widgets) auf dem CiviCRM-Dashboard (der Startseite eurer CiviCRM-Instanz), Diese Module können wichtige Kennzahlen, Listen oder Diagramme anzeigen. So könnt ihr einen Überblick über wichtige Daten erhalten, ohne groß navigieren zu müssen.

Vorteile Reports/Berichte

- standardisierte Vorlagen

- können als CSV oder direkt als PDF exportiert werden

- Versand via Mail möglich

- einfache Möglichkeit, um "Listen" zu bekommen

- können über Dashlets (s.u.) ins Dashboard integriert werden

Nachteile Reports/Berichte

- Komplexe oder mehrdimensionale Analysen sind nur bedingt umsetzbar

- Anpassungen erfordern teils technisches Wissen oder Erweiterungen

- nicht so flexibel und mächtig wie SearchKit

- Ergebnisse können nicht über die API v4 exportiert werden

Vorteile Dashlets

- Schneller benutzerfreundlicher Überblick: Wichtige Kennzahlen und Trends sind sofort sichtbar. Kein Umweg über Menüs oder Berichte nötig.

- Ihr könnt eigene Berichte als Dashlets einbinden.

- Visuelle Darstellung von Echtzeit-Daten

Nachteile Dashlets

- Es sind nur oberflächliche Analysen (einfache Kennzahlen, Balken- und Tortendiagramme, Listen) möglich – keine komplexen Auswertungen.

- Eingeschränkte Visualisierung: Grafiken sind funktional, aber optisch und interaktiv recht einfach.

- Zu viele Dashlets können die Dashboard-Performance verlangsamen.

- Individuelle oder dynamische Visualisierungen erfordern Entwicklungsaufwand.

Fazit

CiviCRM-Berichte sind gut geeignet, um in CiviCRM Überblick zu bekommen über operative Abläufe und Kennzahlen. Berichte eignen sich auch für die Erstellung von Datensätzen zur weiteren Verarbeitung in anderen Tools (z.B. Excel). Allerdings können diese Datensätze dann nur manuell exportiert werden, während dies bei SearchKit über die API möglich ist. Generell ist SearchKit und ChartKit

Die Dashlet-Funktion ist praktisch, um bestimmte Übersichten direkt auf der Startseite einzubinden. Für tiefergehende Datenanalysen oder professionelle Visualisierungen (z. B. mit interaktiven Diagrammen oder Data-Dashboards) reichen Berichte/Reports und Dashlets jedoch nicht aus – hier sind externe Tools oder individuelle Erweiterungen gefragt.

Weitere CiviCRM Tools

Neben SearchKit und ChartKit und Reports/Berichten gibt es noch weitere Tools und Erweiterungen in CiviCRM, mithilfe derer ihr Daten analysieren und visualisieren könnt. Hier gehen wir noch auf die Erweiterung Civisualize und spezifische Erweiterungen ein.

Civisualize

Civisualize ist eine CiviCRM Erweiterung, mit der Nutzer*innen Grafiken erstellen können. Für die gängigsten CiviCRM Komponenten wie Kontakte, Zuwendungen, Veranstaltungen und Rundschreiben liefert Civisualize einige Überblicksgrafiken mit. Außerdem gibt es ein Mini-Dashboard für Spendentrends ("Donor Trends"). Eine Beschreibung der schon inkludierten Visualisierungen findet sich hier (Englisch). In der Basis-Installation findet ihr Civisualize unter Berichte -> Civisualize.

Eigene bzw. zusätzliche Grafiken können mithilfe der Javascript Bibliotheken d3.js und dc.js erstellt werden. Diese Funktion richtet sich jedoch primär an Entwickler*innen, die sich mit SQL, der API von CiviCRM und Javascript auskennen.

Vorteile von Civisualize

- Visualisierungen sind integriert in CiviCRM und leicht auffindbar für alle Nutzer*innen

- vorgefertigte Visualisierungen geben einen ersten deskriptiven Einblick in die gängigsten CiviCRM-Datentypen

- Visualisierungen sind prinzipiell interaktiv und erlauben eine rudimentäre Filterung

Nachteile von Civisualize

- ohne tiefergehende technische Kenntnisse können keine eigenen Visualisierungen erstellt werden. Erfordert viel Zeit zur Einarbeitung.

d3.jsist ein ziemlich komplex und die Lernkurve ist steil.1- Visualisierungen können nicht als

pngo.ä. exportiert werden - Dashboards / Visualisierungen können nicht mit Externen geteilt werden

- keine Verknüpfung der Datentypen "out of the box" (Ausnahme: Spendentrends-Dashboard).

Fazit

Civisualize liefert einige potenziell hilfreiche Grafiken "out of the box" und macht diese zugänglich direkt in CiviCRM. Wenn diese vorgefertigten Visualisierungen hilfreich sind für einen ersten Einblick in die Daten für interne Nutzer*innen, kann eine Installation sinnvoll sein. Die Lernkurve, um eigene Datenvisualisierungen zu erstellen, ist zu steil - gerade für nicht-technische Nutzer*innen - um einen Einsatz darüber hinaus zu rechtfertigen, außer es ist zwingend notwendig, dass Visualisierungen direkt in CiviCRM auffindbar sind. Civisualize ist kein Tool, welches eine einfache, zugängliche Analyse von Daten ermöglicht.

Use-Case-spezifsche Extensions

Im Rahmen des Datenvorhabens haben wir uns auf CiviCRM-Komponenten und -Extensions konzentriert, die dediziert auf die Analyse und Visualisierung von Daten ausgelegt sind. Aber auch Extensions, die für spezifische Anwendungsfälle (z.B. Spender*innenanalyse, ...) erstellt wurden, haben z.T. Datenauswertungen und -visualisierungen an Bord. Wir freuen uns über Hinweise zu den Datenkapazitäten von "inhaltlichen" Extensions und nehmen sie gerne in die Liste auf.

Contact Categories

Die Extension Contact Categories bietet die Möglichkeit, Kontakte nach Prioritätsgruppen zu kategorisieren. Prioritätsgruppen können eigenständig konfiguriert werden. Datenanalyse und -visualisierung: Als Datenvisualisierung steht ein Flow-Chart zur Verfügung, der die Übergänge von Kontakten zwischen den verschiedenen Kontaktkategorien visualisiert.

-

Selbst die Entwickler*innen der Extension geben dies zu bedenken: "Be warned, d3 is awesome, but the learning curve is steep." ↩

Excel, Google Sheets & Co.

Mit Tabellenkalkulationsprogrammen wie Excel, Google Sheets und Libre Office Calc könnt ihr Daten erfassen, sie analysieren und grafisch darstellen.

Microsoft Excel

🔢 daten-auswerten 📊 daten-visualisieren 🧹 daten-organisieren

Microsoft Excel ist ein häufig genutztes Tabellenkalkulationsprogramm, mit dem ihr Daten aus CiviCRM oder anderen Quellen strukturieren, analysieren und visualisieren könnt. Ihr könnt damit:

- ... CiviCRM-Daten (z.B. Spenden, Mitglieder oder Events) mithilfe von Pivot-Tabellen, Formeln und Filtern auswerten, um z. B. Spendenentwicklungen zu analysieren oder Zielgruppen zu vergleichen (🔢 daten-auswerten)

- ... mithilfe von Diagrammen die Ergebnisse anschaulich darstellen (📊 daten-visualisieren)

- ... mit Power Query (s.u.) Daten automatisch aktuell halten (🧹 daten-organisieren).

Excel kann sowohl lokal (Desktop-Version) als auch in der Cloud (Excel for the Web) eingesetzt werden.

Vorteile von Excel

- Geringe Einstiegshürde & weit verbreitet: Viele Nutzer*innen kennen Excel bereits, und es entstehen ggf. keine zusätzlichen Kosten, weil Lizenzen bereits vorhanden sind.

- Flexibilität: Excel ermöglicht Datenanalyse, -visualisierung und -management in einem Tool.

- Datenorganisation: in Excel können Daten aus CiviCRM mit Daten aus anderen Quellen zusammengeführt werden

- Integration: Wer die Microsoft Cloud nutzt, kann Excel einfach mit Power BI oder anderen Tools verbinden.

Nachteile von Excel

- "Excel-Parallelwelten": Wenn Nutzer*innen Daten direkt in Excel ändern statt in CiviCRM, entstehen inkonsistente Datenquellen und der Aufwand für die Wiederherstellung einer "Single Source of Truth"1 steigt.

- Datenschutz und Datensouveränität: Bei Excel on the Web müssen Daten mit Microsoft geteilt werden – nicht alle Organisationen möchten / können ihre Daten mit Microsoft teilen.

- Eingeschränkte Visualisierung: Komplexe Dashboards oder maßgeschneiderte Grafiken sind in Excel schwer umsetzbar. Wenn ihr regelmäßiger oder in größerem Umfang auf Dashboards zurückgreifen möchtet, solltet ihr eher auf ein Business Intelligence Tool setzen. Für maßgeschneiderte und komplexere Visualisierungen, die z.B. einmalig für eine Veröffentlichung erstellt werden, sind Programmiersprachen wie Python oder R die beste Wahl.

- Fortgeschrittene Analysen sind in Excel z.T. auch möglich, erfordern aber gute Kenntnis der Funktionen und Formeln. Wenn ihr mittel- bzw. langfristig komplexere Analysemethoden aus dem Bereich Machine Learning2 oder Künstliche Intelligenz3 nutzen möchtet, ist ggf. ein Investment in das Lernen von Python oder R langfristig sinnvoller. Das gleiche gilt für die Analyse von sehr großen Datenmengen (z.B. über 1 Mio. Zeilen).

- Lizenzdschungel: Nicht alle Funktionen sind in jeder Lizenz enthalten. Microsofts Preis- und Lizenzmodelle sind schwer zu durchblicken.

Fazit

Aufgrund seiner Flexibilität ist und bleibt Excel eine gute Option, um diverse Aufgaben rund um die Analyse und Visualisierung von CiviCRM-Daten zu bewältigen. Es ist zugänglich für viele Nutzer*innen. Bei größeren Datenmengen oder höheren Anforderungen an Auswertung, Visualisierung oder Weiterverbreitung von Daten und Ergebnissen sind spezialisierte Tools fast immer eine bessere Wahl.

Excel: Power Query

Power Query ist ein Werkzeug in Excel und Power BI, das Daten aus verschiedenen Quellen (z. B. CiviCRM-API, Datenbanken, Excel-Dateien) importiert, bereinigt und für Analysen aufbereitet. Es automatisiert wiederkehrende Schritte, spart Zeit und reduziert Fehler.

Für die Analyse von CiviCRM-Daten sind v.a. Power Query's Features zum Datenimport relevant. Wir haben Power Query verwendet, um Daten mithilfe der CiviCRM API in Excel zu importieren (siehe unser Experiment zu SearchKit + Excel). Aber auch die anderen Optionen können nützlich sein, z.B. der Import aus anderen Excel-Dateien.

Vorteile von Power Query

- Direkter Datenimport aus CiviCRM mithilfe der CiviCRM API: Ihr könnt Daten automatisch aktualisieren und spart euch den manuellen Schritt des Datenexports aus CiviCRM. Siehe unser Experiment zu SearchKit + Excel.

- Flexibilität: Power Query kann mehr als nur API-Daten laden – eine Einarbeitung lohnt sich.

Nachteile von Power Query

- Nicht ganz einfache Bedienung: Die Benutzeroberfläche ist unübersichtlich, und für fortgeschrittene Funktionen müsst ihr ggf. lernen, in Power Query in der Sprache "M" zu programmieren. Die Dokumentation zu M ist nicht sehr umfangreich und wenn man LLMs um Hilfe fragt, bekommt man manchmal Halluzinationen zurück.

- in Excel für das Web kann man Power Queries nicht bearbeiten, sondern nur ausführen. Das ist unpraktisch, wenn kollaborativ im Browser gearbeitet wird und Queries häufig editiert werden müssen.

- Bewusster Umgang mit Sicherheit nötig: Wenn ihr Power Query verwendet, um mit der CiviCRM API zu kommunizieren, müsst ihr euren CiviCRM API-Schlüssel in der Excel Datei hinterlegen. Das bedeutet, dass ihr diese Datei nicht direkt mit Externen teilen solltet, da diese sonst Zugriff auf euren API-Schlüssel und somit Daten in eurer CiviCRM-Instanz bekommen könnten.

Fazit

Power Query ist eine sinnvolle Option, um CiviCRM-Daten (teil-)automatisch in Excel zu integrieren – das reduziert manuelle Fehler und spart Zeit. Allerdings sollte der Einsatz nur mit einem hohen Bewusstsein für Datensicherheit erfolgen, um API-Schlüssel nicht versehentlich weiterzugeben. Falls bereits (zu) viele Excel-Dateien und -Analysen existieren, hilft Power Query, zentrale Referenzdatensätze zu erstellen, auf die andere Excel-Dateien mit Power Query zugreifen können. Dadurch lassen sich Datenkonsistenz verbessern und Ordnung in die Analyseprozesse bringen.

Google Sheets

Der Text dieses Abschnitts wurde von Mistral erstellt und dann inhaltlich und redaktionell überarbeitet und ergänzt.

🔢 daten-auswerten 📊 daten-visualisieren 🧹 daten-organisieren

Google Sheets ist die kostenlose, webbasierte Tabellenkalkulation von Google Workspace, die sich besonders für kollaborative Datenanalyse eignet. Ihr könnt damit Daten aus CiviCRM oder anderen Quellen analysieren, visualisieren und in Echtzeit gemeinsam bearbeiten.

Vorteile von Google Sheets

- Echtzeit-Kollaboration in der Cloud: Mehrere Nutzer*innen können gleichzeitig an einer Datei in der Cloud arbeiten.

- Einfache Integration: Verbindung mit Google Drive, Data Studio und anderen Google-Diensten.

- Automatisierung: Mit Google Apps Script (s.u.) könnt ihr Daten aus CiviCRM importieren.

Nachteile von Google Sheets

- Performanz bei großen Datensätzen: Bei großen Datenmengen (ab ~100.000 Zeilen) wird Sheets langsam.

- Weniger leistungsfähig als Excel: Komplexe Formeln oder Pivot-Tabellen sind möglich, aber nicht so mächtig.

- Datenschutz und Datensouveränität: Daten werden auf Google-Servern gespeichert – für manche Organisationen keine Option.

Fazit: Google Sheets

Wenn ihr Google Sheets bereits verwendet, ist es eine gute Option, um kollaborativ und cloud-basiert mit euren CiviCRM-Daten zu arbeiten. Sheets eignet sich besonders gut für einfache bis mittelkomplexe Datenauswertungen und Visualisierungen für den internen Gebrauch. Aufgrund der Datenschutzproblematik solltet ihr vermeiden, personenbezogene Daten in Google Sheets zu speichern. Eine Option kann sein, Daten in SearchKit vorab zu aggregieren.

Google Apps Script

Google Apps Script ist eine JavaScript-basierte Programmiersprache, mit der ihr u.a. Abläufe in Google Sheets automatisieren könnt. Mit AppsScript können wir CiviCRM-Daten mithilfe der CiviCRM-API direkt in Google Sheets laden.

Vorteile von Google Apps Script

- Kostenlos und integriert: Keine zusätzliche Software nötig – läuft direkt in Google Sheets.

- Direkter Datenimport aus CiviCRM mithilfe der CiviCRM API: Ihr könnt Daten automatisch aktualisieren und spart euch den manuellen Schritt des Datenexports aus CiviCRM. Siehe unser Experiment zu SearchKit + Google Sheets.

Nachteile von Google Apps Script

- Erfordert Grundkenntnisse in JavaScript.

- Eingeschränkte Performance: Bei komplexen Skripten oder großen Datenmengen kann es langsam werden.

- Abhängigkeit von Google: Skripte laufen nur in der Google Workspace-Umgebung.

Fazit: Google Apps Script